Z Skrypty dla studentów Ekonofizyki UPGOW

(Utworzył nową stronę „==Procesy Poissona== ===Proces urodzin=== W rozdziale 5 podaliśmy kilka przykładów schematu Bernoulliego. Przypomnijmy przykład 3: Rozważamy przedział licz…”)

następna edycja →

Wersja z 20:02, 16 mar 2010

Spis treści |

Procesy Poissona

Proces urodzin

W rozdziale 5 podaliśmy kilka przykładów schematu Bernoulliego. Przypomnijmy przykład 3:

Rozważamy przedział liczbowy \([0, T]\). Z przedziału tego wybieram losowo jeden punkt, jedną liczbę. Ponieważ wszystkie liczby są "równo rozłożone", więc prawdopodobieństwo tego, że punkt ten jest w przedziale \((t_1, t_2)\subset [0, T] \) wynosi

\(P(A)= p = \frac{t_2 -t_1}{T}\)

Jeżeli wylosowany punkt jest w tym przedziale, uważam to za sukces. Wybieram teraz losowo n punktów z przedzialu \([0, T]\). Prawdopodobieństwo tego, że k z tych wszystkich n-punktów będzie w przedziale \((t_1, t_2)\subset [0, T] \) jest określone przez rozkład dwumianowy \(p_n(k)\). Jeżeli przedział \([0, T]\) będzie przedziałem czasowym, to w przedziale tym mam n losowych chwil czasu oraz \(k \le n\) losowych chwil czasu w przedziale \((t_1, t_2)\subset [0, T] \). Teraz dokonuję takiego samego przejścia granicznego jak w twierdzeniu Poissona

\(n \to \infty, \;\;\; p \to 0 \;\;\;\; \mbox{ale} \;\;n\cdot p = \lambda \)

co udaje mi się osiągnąć gdy założę że \(T \to \infty\) przy czym

\(\mu = \frac{n}{T}\)

jest stałą wielkością i oznacza ilość losowych punktów w jednostkowym przedziale, czyli gęstość losowo wybranych punktów na osi czasu. Przy takim skalowaniu otrzymam wyrażenie na parametr

\(\lambda = \mu (t_2 -t_1) \;\)

Przypiszmy teraz każdej losowej chwili czasu akt narodzin dziecka. Prawdopodobieństwo tego że w przedziale \((t_1, t_2) \) jest k-punktów odpowiada prawdopodobieństwu tego że w przedziale czasu \((t_1, t_2) \) urodziło się k dzieci. W ten sposób otrzymujemy losowy proces urodzin. Elementem losowym jest czas narodzin. Wynikiem jest liczba dzieci \(N(t) \) w pewnej chwili czasu \(t\). Rozkład prawdopodobieństwa jest dany przez rozklad Poissona:

Przyjmijmy teraz, że \(t_1 = 0\) i \(t_2 =t\). Wówczas \(t_2 - t_1 =t-0=t\) oraz

jest prawdopodobieństwem tego, że w przedziale czasu \((0, t)\) urodziło się k dzieci. Jeżeli liczbę urodzonych dzieci oznaczymy przez \(N(t)\) to otrzymamy proces stochastyczny nazywany procesem urodzin. Założymy, że \(N(0) = 0\). Oczywiście nie jest to bezwzględny wymóg, ale konwencja. Równie dobrze mógłbym badać dowolny inny stan początkowy \(N(0)\). Proces urodzin tak jak każda zmienna losowa o rozkladzie Poissona przyjmuje wartości całkowite nieujemne:

\(N(t) = \{0, 1, 2, \dots\} \)

Jeżeli \(N(t) = k\) to mówimy, że układ jest w stanie \(k\). Takie sformułowanie jest często stosowane przez fizyków, zwłaszcza w kontekście fizyki kwantowej, gdzie stanami mogą być poziomy energetyczne układów kwantowych. Proces urodzin odpowiadałby przejściu z jednego poziomu energetycznego do najbilższego wyższego poziomu energetycznego.Przejście do stanu o niższej energii nie jest opisane procesem urodzin, ale procesem urodzin i smierci.

Z materiału zawartego w Dodatku 20.5 wynika, że przyrosty procesu urodzin \(N(t_2) - N(t_1)\) oraz \(N(t_4) - N(t_3)\) na nieprzekrywających sie przedziałach \((t_1, t_2)\) oraz \((t_3, t_4)\) są zmiennymi losowymi niezależnymi. Jest to bardzo ważna własność procesu urodzin o poissonowskiej statystyce losowych chwil urodzin \(t_i\). Z Równania (1) widać, że przyrost procesu urodzin \(N(t_2) - N(t_1)\) jest stacjonarny, to znaczy, że prawdopodobieństwu tego że w przedziale czasu \((t_1, t_2) \) urodziło się k dzieci zależy od różnicy czasów \(t_2-t_1\), a nie zależy od tego gdzie te chwile czasu \(t_1\) i \(t_2\) są na osi czasu. Jeżeli tak jest, to w ogolnym przypadku mówimy, że proces stochastyczny ma przyrosty stacjonarne. Uwaga: sam proces nie jest stacjonarny ponieważ rozkład jednowymiarowy (2) zależy od czasu ale proces ma stacjonarne przyrosty!

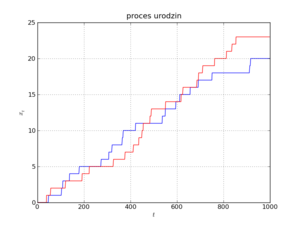

Na Rysunku pokazano dwie realizacje tego procesu. Realizacje te są nieciągłymi i niemalejącymi funkcjami czasu i są to funkcje schodkowe o skoku 1, przy czym skok następuje w losowych chwilach czasu \(t_i\) (zakładamy, że tylko jeden osobnik rodzi się w danym momencie czasu \(t_i\) i w rzeczywistości jest to prawda abstrahując od kwestii spornych przy cesarskim cięciu w przypadku wielodzietnych ciąży). Funkcje schodkowe można zapisać przy pomocy funkcji teta Heaviside'a, więc proces urodzin \(N(t)\) można przedstawić w elegenckiej matematycznej postaci:

Aby otrzymać jedną realizację procesu urodzin w przedziale czasu \([0, T]\), należy losowo wybrać w tym przedziale punkty \(t_i\) które są momentami urodzenia. Mówimy, że punkty te mają statystykę Poissona, mając na myśli ich jednorodne (ale losowe) rozłożenie na osi czasu, patrz Rozdział 6. Mimo że realizacje są funkcjami nieciągłymi (punktami nieciągłości są skoki), proces ten jest procesem ciągłym w sensie średnio-kwadratowym! Co to oznacza? Pogladowo oznacza to tyle, że jeżeli wybiorę jakiś punkt \(t\) na osi czasu, to realizacje będą ciagłe w tym punkcie. Inaczej mówiąc, prawdopodobieństwo tego, że punkt \(t\) "trafi" w nieciągłość (w skok schodka) jest zerowe!

Podsumowując, możemy to wszystko zebrać w matematyczną definicję procesu stochastycznego Poissona (lub poissonowskiego procesu urodzin).

DEFINICJA

Procesem Poissona \(N(t)\) nazywamy proces stochastyczny o następujących wlasnościach:

- Przestrzenią stanów jest zbiór liczb całkowitych nieujemnych, \(X=\{k\}_0^{\infty}\; = \{0, 1, 2, \dots \}\)

- \(N(0) = 0 \; \) (proces startujący z zera)

- \(N(t_2) - N(t_1)\; \) jest liczbą punktów w przedziale \((t_1, t_2)\)

- \(N(t)\) ma stacjonarne i niezależne przyrosty na nieprzekrywających się przedziałach o rozkładzie prawdopodobieństwa

WŁASNOŚCI PROCESU POISSONA

1. Wartość średnia

\(m(t) = \langle N(t) \rangle = \mu t\)

Z tej relacji mamy interpretację parametru

\(\mu = \frac{\langle N(t) \rangle}{t} \)

Parametr \(\mu\) to średnia liczba punktów w jednostce czasu lub średnia liczba urodzeń w jednostce czasu. Ten parametr może być oszacowany z danych statystycznych czy też z danych doświadczalnych.

2. Moment statystyczny drugiego rzędu

\(\langle N^2(t) \rangle = \mu^2 t^2 + \mu t\; \)

3. Stąd mamy relację dla fluktuacji procesu

\(\sigma^2(t) = \langle N^2(t) \rangle - \langle N(t) \rangle^2 = \mu t \; \)

4. Stąd mamy średnio-kwadratowe odchylenie

\(\sigma(t) = \sqrt{\mu t} \; \)

Ważna jest interpretacja tego wyniku: Fluktuacje procesu narastają liniowo w czasie. To oznacza, że im dłuższy jest czas tym odchylenia od wartości średniej mogą byc coraz większe. Można przeprowadzić następujące dewagacje:

Badam proces urodzin i przeprowadzam szereg symulacji komputerowych tego procesu. Otrzymuję wiele realizacji procesu urodzin. Z analizy tych realizacji mogę metodami statystyki otrzymać wartość średnią procesu. Oczekuję (coś to ma wspolnego z warościa oczekiwaną czyli wartościa średnią), że wiele realizacji bedzie przebiegać w pobliżu wartości średniej. Owszem to prawda, ale jednocześnie pojawiają mi się realizacje które daleko odbiegają od wartości średniej. Im dłuższy jest ten czas, tym większe odchylenia od wartości średniej mogę zaobserwować. Jest to własność, która w deterministycznym świecie nie występuje (deterministyczny świat nie jest światem rzeczywistym, jest jego idealizacją, bardziej lub mniej adekwatną). Do tego zagadnienia jeszcze powrócę, gdy będę rozważać procesy którym odpowiadaja zmienne losowe typu ciągłego.

Oczywiście powyższe relacje można (mutatis mutandis) podać dla przyrostów procesu Poissona:

1. Wartość średnia przyrostów procesu Poissona

\(\langle N(t_2) - N(t_1)\rangle = \mu (t_2-t_1)\)

2. Moment statystyczny drugiego rzędu dla przyrostów procesu Possona

\(\langle [N(t_2) - N(t_1)]^2 \rangle = \mu^2 (t_2-t_1)^2 + \mu (t_2-t_1) \; \)

3. Funkcja korelacyjna procesu Poissona

gdzie funkcja dwóch zmiennych \(\mbox{min}(x, y) \;\) oznacza wartość mniejszej liczby z dwóch liczb \(x\) i \(y\):

Z powyższych relacji wynika, że proces urodzin jest procesem skorelowanym.

Pokażemy, w jaki sposób można wyznaczyć postać funkcji korelacyjnej. Rozpatrzymy dwa przypadki pamiętając że \(N(t_0) = N(0) =0\):

(i) Niech \(t_2 > t_1 > t_0=0\). Przyrosty \(N(t_2) - N(t_1) \) oraz \(N(t_1) - N(t_0) \) są zmiennymi losowymi niezależnymi dla których

- \(\langle[N(t_2) - N(t_1)] [ N(t_1) - N(t_0)] \rangle = \langle N(t_2) - N(t_1) \rangle \cdot \langle N(t_1) - N(t_0) \rangle = \mu (t_2 -t_1) \; \mu t_1\)

Skorzystaliśmy tu z tego, że wartość średnia iloczynu zmiennych losowych niezależnych jest iloczynem wartości średnich zmiennych losowych niezależnych. Z drugiej strony, wymnożymy wyrażenia w nawiasach pamietając, że \(N(t_0) = N(0) = 0\) (proces Poissona startuje z zera). Wówczas otrzymamy

- \(\langle N(t_2) N(t_1) - N^2(t_1) \rangle = \langle N(t_2) N(t_1) \rangle - \langle N^2(t_1)\rangle =\mu (t_2 -t_1) \; \mu t_1\)

Stąd wynika, że

- \(\langle N(t_2) N(t_1) \rangle = \mu (t_2 -t_1) \; \mu t_1 +\langle N^2(t_1)\rangle = \mu (t_2 -t_1) \; \mu t_1 + \mu^2 t_1^2 + \mu t_1 = \mu^2 t_2 t_1 + \mu t_1 \; \; \; \; \mbox{dla} \; \; \; t_2 > t_1\)

(ii) Niech \(t_1 > t_2 > t_0=0\). Przyrosty \(N(t_1) - N(t_2) \) oraz \(N(t_2) - N(t_0) \) są zmiennymi losowymi niezależnymi. Możemy powtórzyć trzy kroki analogiczne do tych w powyższych trzech równanich otrzymując

- \(\langle N(t_1) N(t_2)\rangle = \mu (t_1 -t_2) \; \mu t_2 + \langle N^2(t_2)\rangle = \mu^2 t_1 t_2 + \mu t_2\; \; \; \; \mbox{dla} \; \; \; t_1 > t_2\)

Ponieważ

- \(\langle N(t_2) N(t_1)\rangle = \langle N(t_1) N(t_2)\rangle\)

to z powyższych równań otrzymujemy relację (5).

Rozkład prawdopodobieństwa Poissona (2) spełnia nastepujący układ równań ewolucji (ang. master equations), patrz RYSUNEK,

RYSUNEK

Słuszność tego układu równań można sprawdzić bezpośrednim rachunkiem, z jednej strony różniczkując wyrażenie dla \(p_k(t)\), z drugiej strony wstawiając wrażenia na \(p_k(t)\) oraz \(p_{k-1}(t)\). Równania te mają też jasną interpretację. W tym celu spojrzymy nieco inaczej na nasz proces. Mówimy, że układ jest w stanie \(k\) jeżeli

\(N(t) =k\;\)

Stan układu jest określony przez możliwe wartości populacji w danej chwili czasu, \(k=0, 1, 2, ....\). Zmiana stanu k układu w danej chwili czasu, opisywana przez tempo zmian czyli pochodną \(dp_k(t)/dt\), może zachodzić z dwóch powodów: albo stan k pojawia się ze stanu (k-1) ponieważ następuje akt narodzin, albo stan k znika i uklad przechodzi do stanu k+1 (ponieważ następuje akt narodzin). W wyrażeniu (8) wyraz \(\mu p_{k-1}(t)\;\) wchodzi ze znakiem dodatnim ponieważ stan k pojawia się ze stanu k-1; wyraz \(\mu p_{k}(t)\;\) wchodzi ze znakiem ujemnym ponieważ stan k znika i układ przechodzi w stan k+1 (ponieważ ktos sie urodził). Jest to nic innego jak równanie bilansu.

Proces urodzin i śmierci

W procesie urodzin, liczba osobników nie maleje. W rzeczywistości zachodzą też procesy śmierci, czyli ubytek osobników. Proces ten można uwględnić w relacji (15) w następujący sposób:

gdzie zmienne losowe \(\xi_i=\{1, -1\}\) są niezależne między sobą i są o identycznych rozkładach prawdopodobieństa:

\(P(\xi_i = 1) = p, \; \; \; P(\xi_i = -1) = q, \; \; \; p+q=1\)

Wartość zmiennej losowej \(\xi_i = 1\) odpowiada narodzinom (dodajemy jeden schodek), natomiast wartość zmiennej losowej \(\xi_i = -1\) odpowiada śmierci (odejmujemy jeden schodek). Jeżeli \(p=q=1/2\) to statystycznie mamy równowagę pomiędzy procesem urodzin i śmierci; jeżeli \(p > q\) to populacja powinna rozwijać się; jeżeli \(p < q\) to populacja powinna z czasem zamierać. W Równaniu (9) dodaliśmy składnik \(N(0)\), czyli stan początkowy populacji. Gdyby w chwili początkowej \(N(0)=0\), to pojawiłby się problem, gdyby w pierwszym kroku \(\xi_1=-1\), czyli powinien nastąpić akt śmierci. Ależ któż to miałby umrzeć, jeżeli nie ma żadnych osobników gdy \(N(0)=0\).

Proces urodzin i śmierci dobrze jest modelować i analizować opierając się na równaniach ewolucji dla rozkładu prawdopodobieństwa. Aby takie równania otrzymać, można uogólnić wywody przedstawione w poprzednim rozdziale 8.1. W "porządnej" teorii ogólniejsze równania ewolucji są wyprowadzane ściśle bazując na własnościach np. procesów Markowa. W procesie urodzin i śmierci zmiana stanu k następuje z 4 powodów (patrz RYSUNEK)

- stan k pojawia się ze stanu (k-1) ponieważ ktoś się urodził (przejście to opisuje parametr \(\lambda_{k-1}\) który w ogólnym przypadku zależy od stanu \(k-1\))

- stan k znika przechodząc w stan (k+1) ponieważ ktoś się urodził (przejście to opisuje parametr \(\lambda_{k}\) który w ogólnym przypadku zależy od stanu \(k\))

- stan k pojawia się ze stanu (k+1) ponieważ ktoś umarł (przejście to opisuje parametr \(\mu_{k+1}\) )

- stan k znika przechodząc w stan (k-1) ponieważ ktoś umarł (przejście to opisuje parametr \(\mu_{k}\) )

Równania bilansu przyjmują postać

W ogólnym przypadku, dla dowolnej zależności parametrów \(\lambda_k\) i \(\mu_k\) od \(k\), nie są znane rozwiązania tego układu równań. Szczególne przypadki są analizowane w książce: N. S. Goel and N Richter-Dyn, Stochastic models in biology (1974, Academic Press, New York).

Jeżeli \(N(t) = k\) to mówimy, że układ jest w stanie \(k\). Stanem tym może być liczba populacji, numer węzła sieci krystalicznej, stan energetyczny układu kwantowego. Powyższy proces urodzin i śmierci opisuje przejścia tylko pomiędzy sąsiednimi stanami \((k-1) - k - (k+1)\). Przejścia pomiędzy stanem \(k\) a stanem \((k+2)\) czy \((k-2)\) lu dalszymi nie są uwzględnione w tym opisie. W terminologi urodzin i śmierci, wyklucza się przypadki urodzin i/lub śmierci jednocześnie 2 osobników w tej samej chwili czasu.

Uogólnienia procesu Poissona

Uogólnienia procesu Poissona można konstruować wieloma metodami. Przykład jednej z metod jest przedstawiony w Rozdziale 8.2, we wzorze (9). Wzór ten można łatwo uogólnić dla przypadków gdy:

- zmiany stanów mogą zachodzic z dowolną amplitudą (w procesie urodzin możliwe były zmiany dyskretne o 1, w procesie urodzin i śmierci możliwe były dyskretne zmiany o 1 lub -1)

- amplituda zmian może być deterministyczna lub losowa (w procesie urodzin zmiana o 1 była deterministyczna, w procesie urodzin i śmierci zmiany były losowe o 1 lub -1)

Uogólnienie procesu Poissona będzie określone przez formułę

Proces ten zdefiniowalismy tak, aby jego wartość średnia \(\langle N(t)\rangle = 0\).

Zmienne losowe \( \{a_i\} \;\) są niezależne między sobą i są o identycznym (wspólnym, takim samym) rozkładzie prawdopodobieństwa określonym przez gęstość prawdopodobieństwa \(\rho (a)\;\). Zmienne losowe \( \{a_i\} \;\) mogą być dyskretne lub ciągłe, ich rozkład może być symetryczny lub niesymetryczny. Jeżeli jest symetryczny to gęstość prawdopodobieństwa \(\rho (a) =\rho (-a) \;\) jest funkcją parzystą (symetryczną ze względu na transformację \(a \to -a\)). W tym przypadku wartość średnia \(\langle a_i\rangle = 0\;\). W przypadku symetrycznej gęstości prawdopodobieństwa \(\rho (a)\;\), przyrosty procesu mogą być zarówno dodatnie jak i ujemne z tym samym prawdopodobieństwem. Przykładem może być gęstość prawdopodobieństwa

Jest ona przedstawiona na Rysunku. Wnioskujemy, że bardziej prawdopodobne są małe przyrosty procesu (dla małych wartości \(a_i\;\), gęstość jest duża, a całka z gęstości po danym przedziale jest prawdopodobieństwem tego że zmienna losowa \(a_i\;\) ma wartości z tego przedziału). Duże przyrosty procesu są mało prawdopodobne (dla dużych wartości \(a_i\;\), gęstość jest mała)

Jeżeli gęstość prawdopodobieństwa jest asymetryczna jak w poniższym przykładzie

to możliwe są tylko dodatnie przyrosty procesu \(N(t)\), ponieważ dla ujemnych \(a_i\), gęstość prawdopodobieństwa jest zero.

Powyższa konstrukcja procesu \(N(t)\) i przytoczone przykłady pokazują, że mamy nieskończenie wiele procesów Poissona. Problemem jest to, które mogą modelować rzeczywiste zjawiska. Ale to już inny problem.

Poissonowski ciąg impulsów: biały szum Poissona

Zwykle pod pojęciem szumu kryje się stacjonarny proces stochastyczny o zerowej wartości średniej. Mimo, że średnio jest zerowy, jego wpływ może być potężny. Proces urodzin Poissona nie jest ani stacjonarny ani o zerowej wartości średniej. Uzyskanie wartości średniej nie jest problemem. Zawsze możemy zdefiniować nowy proces będący różnicą procesu i jego wartością średnią:

- \({\tilde N}(t) = N(t) - m(t) = N(t) - \mu t\)

Wówczas

- \(\langle {\tilde N}(t) \rangle = 0\)

Ale ciągle nie jest to proces stacjonarny. z kolei (formalna) pochodna tego procesu

jest procesem stacjonarnym. Proces ten nazywa się poissonowskim ciągiem impulsów. Jedna z jego realizacji jest przedstawiona na Rysunku. Pionowe linie oznaczają impuls o nieskończonej amplitudzie. Nie jest to możliwe w realnym świecie, ale taka idealizacja jest usprawiedliwiona w przypadku dużych (ale skończonych) amplitud które bardzo krótko działają. Słowo "dużych" trzeba odnieść do innych wielkości układu. Podobnie jest z wyrażeniem "bardzo krótko". To musi być "bardzo krótko" w porównaniu z innymi skalami czasu w układzie. Każdy konkretny układ wymaga analizy skal czasu, energii, itp. Nie zawsze jest to proste zadanie, aby takie skale znaleźć.

Korzystając z wyników zawartych w Rozdziale 7.2 możemy obliczyć wsartość średnią procesu \(z(t)\) oraz jego funkcje korelacyjną.

Wartość średnia

Funkcja korelacyjna

Aby wyznaczyć funkcję korelacyjną procesu \(z(t)\), należy obliczyć pochodną mieszaną drugiego rzędu funkcji korelacyjnej procesu \(N(t)\). Funkcja korelacji procesu Poissona ma postać (patrz Rozdział 8.1)

\[R(t_2, t_1) = \langle N(t_2) N(t_1)\rangle = \mu^2 \;t_2 \;t_1 + \mu \; \mbox{min}(t_2, t_1)\]

gdzie funkcja dwóch zmiennych \(\mbox{min}(x, y) \;\) oznacza wartość mniejszej liczby z dwóch liczb \(x\) i \(y\):

\( \mbox{min} (x, y) = \left \{ {{x \; \; \mbox{if}\; \; x < y} \atop {y \; \; \mbox{if} \; \; y<x}} \right.\)

Obliczenie pochodnej mieszanej jest trudnm zadaniem dla studentów, dlatego przedstawie rachunki poniżej. Dobrze jest przedstawić funkcję

\(\mbox{min}(t_2, t_1) \;\) w innej postaci, a mianowicie

- \(\mbox{min}(t_2, t_1) = t_2 \theta(t_1 -t_2) + t_1 \theta (t_2 -t_1)\;\)

gdzie \(\theta(t)\;\) jest funkcją schodkowa Heaviside'a. Pochodna (dystrybucyjna) tej funkcji jest deltą Diraca,

- \(\frac{d\theta(t)}{dt} = \delta (t)\)

Obliczmy zatem pochodną cząstkową

- \(\frac{\partial \mbox{min}(t_2, t_1)}{\partial t_1} = t_2 \delta(t_1 -t_2) + \theta (t_2 -t_1) -t_1 \delta(t_2 -t_1) = \theta (t_2 -t_1)\;\)

ponieważ w sensie dystrybucyjnym zachodzi równość

- \( t_2 \delta(t_1 -t_2) = t_1 \delta(t_2 -t_1)\;\)

Obliczenie pochodnej wzgledem \(t_2 \) jest łatwe

- \(\frac{\partial^2 \mbox{min}(t_2, t_1)}{\partial t_2\,\partial t_1} = \frac{\partial \theta (t_2 -t_1)}{\partial t_2} = \delta(t_2 -t_1)\;\)

Możemy teraz wyznaczyć funkcję korelacyjną procesu \(z(t)\):

Wartość średnia procesu \(z(t)\) jest niezalezna od czasu, natomiast funkcja korelacyjna zależy tylko od różnicy czasów \(t_2-t_1\), a ze względu na własności delty Diraca mozna powiedzieć, że funkcja korelacyjna zależy tylko od bezwzględnej wartości różnicy czasów \(|t_2-t_1|\). Z tych dwóch własności wnioskujemy, że \(z(t)\) jest procesem stacjonarnym. Ponieważ jest on \(\delta\)-skorelowany, więc nazywamy go białym szumem poissonowskim.

Można zdefiniować biały szum poissonowski o zerowej wartości średniej:

- \(y(t) = z(t) - \mu \;\)

Wówczas

- \(\langle y(t)\rangle =0, \; \; \; \langle y(t_2)y(t_1) \rangle = \mu \delta(t_2-t_1)\)

Z uogólnionych procesów Poissona także można otrzymać biały szum który jest ich pochodną ze względu na czas.