Z Skrypty dla studentów Ekonofizyki UPGOW

(→Elementy teorii prawdopodobieństa) |

(→Szum dychotomiczny) |

||

| Linia 1098: | Linia 1098: | ||

Z uogólnionych procesów Poissona także można otrzymać biały szum który jest ich pochodną ze względu na czas. | Z uogólnionych procesów Poissona także można otrzymać biały szum który jest ich pochodną ze względu na czas. | ||

| - | ==Szum dychotomiczny== | + | ===Szum dychotomiczny=== |

==Błądzenie przypadkowe== | ==Błądzenie przypadkowe== | ||

Wersja z 19:39, 16 mar 2010

PROCESY I ZJAWISKA LOSOWE

Jerzy Łuczka

Skrypt dla studentów ekonofizyki

WAZNE - postaraj sie podzielic tekst na glowne rozdzialy (tak by bylo z 10 sztuk)

Spis treści

- Wstęp

- Zbiory

- Elementy teorii prawdopodobieństa

- Próby i schemat Bernoulliego

- Twierdzenie Poissona i rozkład Poissona

- Procesy Stochastyczne

Próby i schemat Bernoulliego

Próbą Bernoulliego nazywamy dowolne doświadczenie losowe, w którym pytam tylko o dwa możliwe wyniki, będące zdarzeniami przeciwnymi. Jeden z wyników nazywam sukcesem, drugi - porażką. Przykładów takich doświadczeń mamy tysiące. Mogą one być bardziej lub mniej rzeczywiste, część może być bardziej lub mniej losowe. Używam tu nieprecyzyjnych określeń, ale czytelnik będzie wiedział o co mi chodzi po zapoznaniu się z poniższymi przykładami.

W rzucie monetą otrzymam orła czy reszkę; w rzucie kostką otrzymam parzystą lub nieparzystą liczbę oczek; dzwonię do przyjaciela: uzyskam połączenie lub nie; strzelam do tarczy: trafię w koło zawierające co najmniej 8 lub nie; pojadę do kina autobusem: odjedzie autobus planowo (plus minus 5 minut) lub nie; czy w Będzinie 15 marca pierwsze urodzone dziecko będzie chłopcem czy nie; itd.

Nie wszystkie te przykłady są idealną próbą Bernoulliego. Ale często idealizujemy, zakładając że tak jest. Metoda idealizacji jest nagminnie stosowana (o dziwo!) w naukach ścisłych. Dla przykładu, w mechanice klasycznej badamy ruch punktu materialnego. Takim punktem materialnym może być kulka metalowa, kamień, a czasami nawet lokomotywa. Więc my też będziemy zakładali, że nasze przykłady sa idealnymi próbami Bernoulliego.

Teraz przeprowadzamy doświadczenie polegające na n-krotnym powtórzeniu ustalonej próby Bernoulliego, przy założeniu, że wynik każdej próby nie zależy od wyników prób poprzednich i nie wpływa na wyniki prób następnych. Niezależność prób polega na tym, że dowolny wynik jednej próby nie wpływa na prawdopodobieństwo pojawienia się każdego z wyników w następnej próbie. Schematem n-prób Bernoulliego nazywamy ciąg n-niezależnych powtórzeń tej samej próby Widac z powyższych przykłasdów Bernoulliego. W każdej z n prób Bernoulliego, przestrzeń probabilistyczną \(\Omega_i \; (i=1, 2, ... , n) \) rozbijamy na dwa podzbiory \(A_1\) i jego dopełnienie \(A_2\), to znaczy

\(\Omega_i = A_1 \cup A_2, \; \;\ \; A_1 \cap A_2 = \empty\)

Mamy dwa zdarzenia: zdarzenie \(A_1\) które nazwiemy umownie sukcesem i zdarzenie \(A_2\) które nazwiemy umownie porażką. Mamy pojedyńcze doświadczenie E i w wyniku tego doświadczenie możemy otrzymać albo sukces \(A_1\) albo porażkę \(A_2\). Niech prawdopodobieństwo sukcesu wynosi \(p=p_1\) i porażki \(q=p_2\), czyli

\(P(A_1) =p_1 =p, \; \; \; \; \;\;\;\;\; P(A_2) = p_2 = q, \; \;\;\;\;\; \; \; p_1+p_2=p+q=1\)

W pojedyńczej próbie definiujemy zmienną losową \(\xi_i\) w następujący sposób:

\(\xi_i(A_1) = 1\;\)

\(\xi_i(A_2) = 0\;\)

Zauważmy, że prawdopodobieństwo tego że \(\xi_i=1\) wynosi tyle samo co prawdopodobieństwo tego że otrzymamy \(A_1\), czyli

\(Pr (\xi_i = 1) = P(A_1) = p_1\;\)

Podobnie, prawdopodobieństwo tego że \(\xi_i=0\) wynosi tyle samo co prawdopodobieństwo tego że otrzymamy \(A_2\), czyli

\(Pr (\xi_i = 0) = P(A_2) = p_2 \;\)

Ponieważ zmienna losowa przyjmuje dwie wartości, więc jej dystrybuanta składa się z dwóch schodków:

\(F_{\xi_i}(x) = p_1 \theta(x-1) + p_2 \theta (x-0) = p \theta(x-1) + q\theta (x-0) \)

Pytamy, jakie jest prawdopodobieństwo tego, że w schemacie Bernoulliego o n próbach sukces otrzyma się dokładnie k razy? Albo pytamy równoważnie: jakie jest prawdopodobieństwo tego, że w \(n\) niezależnych doświadczeniach zdarzenie \(A_1\) pojawi się k razy? W schemacie n-prób Bernoulliego, ilość sukcesów jest nową zmienną losową, którą oznaczymy przez \(\eta\), Jakie wartości może przyjmować \(\eta\)? To jest to samo pytanie: ile razy mogę otrzymać orła w n rzutach monetą? Oczywiście orła mogę otrzymać 0 razy, albo 1 raz, może 2 razy albo 3 razy, 4 razy, ...., n razy. Więc matematycznie mogę to sformułować definiując zmienna losową \(\eta\) w następujący sposób:

\(\eta = \xi_1 + \xi_2 + \xi_3 + ... + \xi_n\;\)

Każda ze zmiennych losowych \(\xi_i = (1, 0)\), więc

\(\eta = \{0, 1, 2, ..., n\}\;\)

Pytanie o to jakie jest prawdopodobieństwo tego, że w schemacie Bernoulliego o n próbach otrzymamy k razy sukces jest pytaniem o to jest prawdopodobieństwo tego że zmienna losowa \(\eta = k \). Odpowiedź jest znana od wieków: prawdopodobieństwo to dane jest przez rozkład dwumianowy:

Warunek unormowania ma postać

\( \sum_{k=0}^n p_n(k) = \sum_{k=0}^n {n \choose k} \cdot p^k \cdot q^{n-k} =1 \)

Przepiszemy ten rozkład jeszcze raz wprowadzając oznaczenia:

\(k_1=k, \; \;\; \;k_2 = n- k = n -k_1 \;\)

Wówczas

Zapis ten nie jest standardowy (i miejscami mylący) ale w wyrażeniu tym \(k_1\) oraz \(k_2\) występują w symetryczny sposób. Pamietajmy też, że

\(p_1+ p_2=1, \; \; \; k_1 +k_2=n \)

Taka symetryczna forma zapisu pozwala na łatwe uogólnienie schematu Bernoulliego. Poniżej przedstawimy uogólniony schemat Bernoulliego który ma zasadnicze znaczenie w problemie zależności lub niezależności zmiennych losowych oraz w teorii procesów stochastycznych.

Ważne przykłady prób i schematów Bernoulliego

1. Rzut monetą (możliwe wyniki: orzeł-reszka) lub kostką do gry (możliwe wyniki: parzysta ilość oczek-nieparzysta ilość oczek)

W tym przypadku

\( p = q = \frac{1}{2} \)

oraz prawdopodobieństwo tego, że w n rzutach wypadnie k razy orzeł (lub parzysta liczba oczek) wynosi

\(P\{\eta = k\} = p_n(k) = \frac{1}{2^n} {n \choose k} \)

2. Losowo ktoś do mnie zadzwoni w przedziale czasowym \([0, T]\). Sukcesem nazwę zdarzenie A polegające na tym, że ktoś do mnie zadzwoni w przedziale \((t_1, t_2) \subset [0, T] \). Prawdopodobieństwo tego, że osoba ta zadzwoni akurat w przedziale \((t_1, t_2) \subset [0, T] \) wynosi

\(p = \frac{t_2 -t_1}{T}\)

Zakładam, że każda chwila czasu jest równouprawniona (co nie jest realnym założeniem, ponieważ ludzie częściej dzwonią około godziny 17 niż około godziny 3 w nocy). To, że ktoś do mnie zadzwoni w przedziale czasowym \([0, T]\) uważam za sukces, a to że nie zadzwoni - za porażkę (w życiu czasami jest odwrotnie). Tak więc

\(P(A)= p = \frac{t_2 -t_1}{T}\)

Natomiast

\(P(A')= q = 1-p = 1 - \frac{t_2 -t_1}{T}\)

Niech w przedziale \([0, T]\) będzie n-rozmów telefonicznych, które następują losowo i całkowicie niezależnie od siebie. Jest to schemat Bernoulliego. Prawdopodobieństwo tego, że k z tych wszystkich n-rozmów będzie w przedziale \((t_1, t_2) \subset [0, T] \) jest określone przez rozkład dwumianowy \(p_n(k)\).

3. Powyższy przykład, mający wiele mankamantów jak na idealny schemat Bernoulliego, można uogólnić ale przez to uczynić go bardziej abstrakcyjnym. Rozważmy przedział liczbowy \([0, T]\). Może to być przedział czasu. Z przedziału tego wybieram losowo jeden punkt, jedną liczbę. Ponieważ wszystkie liczby są "równo rozłożone", więc prawdopodobieństwo tego, że punkt ten jest w przedziale \((t_1, t_2)\subset [0, T] \) wynosi

\(P(A)= p = \frac{t_2 -t_1}{T}\)

Jeżeli wylosowany punkt jest w tym przedziale, uważam to za sukces. Wybieram teraz losowo n punktów z przedzialu \([0, T]\). Prawdopodobieństwo tego, że k z tych wszystkich n-punktów będzie w przedziale \((t_1, t_2)\subset [0, T] \) jest określone przez rozkład dwumianowy \(p_n(k)\).

4. Substancja promieniotwórcza emituje cząstki w losowych chwilach czasu t. W przedziale czasu \([0, T]\) substancja emituje n cząstek. Moment emisji t jest zdarzeniem elementarnym \(\omega=t\) w przestrzenie probalilistycznej \(\Omega = [0, T]\). Zmienną losową jest losowa chwila czasu emisji, \(\xi(\omega) = \xi(t) = t\). Zdarzeniem A nazwę zdarzenie polegające na tym, że moment czasu t emisji cząstki bedzie w przedziale \((t_1, t_2)\subset [0, T] \). Niech prawdopodobieństwo takiego zdarzenia A wynosi

\( p = P\{ t_1 \le t \le t_2 \} = \int_{t_1}^{t_2} \alpha(s) ds\)

przy czym zakładamy, że \(\alpha(s) \ge 0 \) oraz \(\int_{0}^{T} \alpha(s) ds =1\).

Funkcja \(\alpha(t)\) charakteryzuje własności emisyjne substancji promieniotwórczej. I znowu prawdopodobieństwo tego, że k z tych wszystkich n-elektronów zostanie wyemitowanych w przedziale czasu \((t_1, t_2)\subset [0, T] \) jest określone przez rozkład dwumianowy \(p_n(k)\).

Zauważmy, że ten przykład zawiera w sobie dwa poprzednie przykłady. Aby to pokazać, wybierzmy postać funkcji \(\alpha(t)=1/T\) dla wszystkich \(t\in [0, T]\). Wówczas

\( p = \int_{t_1}^{t_2} \alpha(s) ds = \int_{t_1}^{t_2} \frac{1}{T} ds = \frac{1}{T} \int_{t_1}^{t_2} ds = \frac{t_2 -t_1}{T}\)

W tym przypadku mówimy o jednostajnym rozkładzie chwil emisji (punktów, liczb). Substancje radioaktywne nie emitują jednostajnie cząstek: liczba emitowanych cząstek maleje wraz z upływem czasu. Gdybyśmy dostarczali bez przerwy żródła emisji, to można by przybliżać taki proces przez jednostajną emisję. Ale dla przykładu emisja cząstek w lampach elektronowych jest w przybliżeniu jednostajna.

5. O schemacie Bernoulliego można mówić we wszelkiego typu procesach urodzin. Proces emisji też może byc traktowany jako proces urodzin (rodzą się cząstki). Jeżeli coś się pojawia losowo i z czasem przybywa tego to jest to proces urodzin.

Niech w przedziale czasu \( [0, T] \) rodzi sie n dzieci. Pawdopodobieństwo tego, że jedno dziecko urodzi się w przedziale \((t_1, t_2)\subset [0, T] \) wynosi

\(P(A)= p = \frac{t_2 -t_1}{T}\)

I znowu prawdopodobieństwo tego, że k z tych wszystkich n-dzieci urodzi sie w przedziale \((t_1, t_2)\subset [0, T] \) jest określone przez rozkład dwumianowy \(p_n(k)\).

Uogólniony schemat Bernoulliego

Z powyższych przykładów widać, że rozkład dwumianowy pojawia się wszędzie tam, gdzie mamy powtarzające się zjawiska, niezależne od siebie. Zamiast rozbicia zbioru \(\Omega\) na dwa podzbiory i rozważać dwa zdarzenia: sukces-porażka, możemy rozbić zbiór \(\Omega\) na kilka podzbiorów i rozważać kilka zdarzeń. Wówczas otrzymujemy uogólniony schemat Bernoulliego. Dla przykładu rozpatrzymy przypadek trzech podzbiorów. Niech w jednym doświadczeniu ( tu w i-tym doświadczeniu)

\(\Omega_i = A_1 \cup A_2 \cup A_3 \; \; \; \; \; \; \; A_i \cap A_j = \empty \; \; (i\ne j), \; \; \; \; \; i, j =1, 2, 3\)

Niech

\(P(A_i) = p_i, \; \; \; \; \; \; \; \; p_1+p_2+p_3=1\)

Powtarzamy doświadczenie n-razy w sposób niezależny, to znaczy zakładamy, że wynik każdej próby nie zależy od wyników prób poprzednich i nie wpływa na wyniki prób następnych. Prawdopodobieństwo tego, że w n-próbach, zdarzenie \(A_1\) pojawi sie \(k_1\)-razy, zdarzenie \(A_2\) pojawi sie \(k_2\)-razy (a stąd zdarzenie \(A_3\) pojawi sie \(k_3\)-razy) wynosi

przy czym

\(p_1 + p_2 + p_3 = 1, \; \; \; \; \; \; k_1 + k_2 + k_3 = n \; \)

Jest to uogólnienie formuły w Równaniu (2).

Widać teraz, jak łatwo można uogólnić te wzory na przypadek dowolnej liczby zdarzeń \(A_k\) tak aby

\(\Omega_i = A_1 \cup A_2 \dots \cup A_s \; \; \; \; \; \; \; A_i \cap A_j = \empty \; \;(i\ne j), \; \; \; \; \; i, j =1, 2, \dots , s\)

Powróćmy do wzoru (3). Zapis \( p_n(k_1, k_2, k_3 )\;\) jest symetryczny ale mylący, ponieważ \(k_3\) oraz \(p_3\) zależą od pozostałych wielkości. Dlatego przepiszemy relację (3) w postaci

Z tego wzoru wynika, że dwa zdarzenia: \(\{A_1 \; \mbox{zachodzi} \; k_1 \;\mbox{razy}\} \) oraz \(\{A_2 \; \mbox{zachodzi} \; k_2 \;\mbox{razy}\} \) nie są zdarzeniami niezależnymi, to znaczy

gdzie to ostatnie jest rozkładem dwumianowym zdefiniowanym w Równaniu (1). Do tego zagadnienia powrócimy jeszcze. Zobaczymy, że w pewnych granicznych przypadkach, zdarzenia powyższe mogą być niezależne, to znaczy zachodzi równość w (5).

Twierdzenie Poissona i rozkład Poissona

Trzy ostatnie schematy Bernoulliego są podobne. Przykład pierwszy jest inny. Gdzie tkwi ta odmienność. W trzech ostatnich schematach Bernoulliego prawdopodobieństwo p może być łatwo zmieniane poprzez zmianę końców przedziału \((t_1, t_2)\) lub też przez zmianę T. W pierwszym schemacie prawdopodobieństwo p = (1/2) jest "sztywne", nie mozna go zmieniać (abstrahuje tu od zmiany p poprzez fałszowanie monet lub kostek do gry). Rozpatrzymy jeden z granicznych przypadków dla rozkładu dwumianowego.

Twierdzenie Poissona :

Niech

\(n \to \infty\) oraz \(p \to 0\) w taki sposób, aby \(n \cdot p = \lambda = const. \)

Wówczas rozkład dwumianowy dąży do rozkładu

\(\lim_{n \to \infty\ p \to 0} p_n(k) = p(k) = \lim_{n \to \infty\ p \to 0} {n \choose k}p^k (1-p)^{n-k} = e^{-\lambda} \; \frac{\lambda ^k}{k!}\)

Dowód: Ponieważ \(n \cdot p = \lambda \), stąd \(p = \lambda/n \). Wstawimy to do rozkładu dwumianowego.

Zauważmy, że (reperkusja słynnej relacji Eulera definiującej liczbę e)

\(\lim_{n\to\infty} \left(1 - \frac{\lambda}{n}\right)^n = e^{-\lambda} \; \; \)

oraz

\(\lim_{n\to\infty} \left(1 - \frac{\lambda}{n}\right)^k = 1 \)

Czynnik kombinatoryczny

\({n \choose k} = \frac{n!}{k!(n-k)!} = \frac{1\cdot 2 \cdot 3 \dots (n-k-1) (n-k) (n-k+1) (n-k+2)\dots (n-2) (n-1) n }{k! \; 1 \cdot 2 \cdot 3 \dots (n-k-1)(n-k)}\)

\( = \frac{1}{k!} (n-k+1) (n-k+2) \dots (n-2) (n-1) n = \frac{n^k}{k!} \left( 1- \frac{k-1}{n}\right) \left( 1- \frac{k-2}{n}\right) \dots \left( 1- \frac{2}{n}\right) \left( 1- \frac{1}{n}\right) \)

Wszystkie wyrażenia w nawiasach dążą do 1 gdy \(n \to \infty\). Wyrażenie w liczniku \(n^k\) uprości się z takim samym wyrażeniem w mianowniku Równania (6). W resultacie otrzymujemy tezę twierdzenia, czyli rozkład który nazywa się rozkładem Poissona o parametrze \(\lambda\):

\( Pr\{\eta = k\} = p(k) = e^{-\lambda} \; \frac{\lambda ^k}{k!}\)

Zmienna losowa o rozkładzie dwumianowym w schemacie Bernoulliego przyjmowała wartości \(\eta = \{0, 1, 2, ..., n\}\). Ponieważ teraz \(n \to \infty\), więc zmienna losowa o rozkładzie Poissona przyjmuje wartości liczb całkowitych nieujemnych, to znaczy

\(\eta = \{0, 1, 2, 3, ...\} = \{k\}_{k=0}^{\infty} \)

W tym przejściu granicznym żądamy, aby prawdopodobieństwa p(A) pojedyńczego zdarzenia A dążyło do zera. Nie jest to możliwe dla rzutu monetą czy kostką. Ale jest to możliwe w pozostałych zaprezentowanych przykładach.

1. Procesy urodzin (rozmowy telefoniczne, punkty na odcinku)

Rozpatrywaliśmy przedział czasu (przedział liczbowy) \([0, T]\) i prawdopodobieństwo

\(p = \frac{t_2 - t_1}{T}\)

Niech \(n \to \infty\) oraz \(T \to \infty\) w taki sposób aby \(\frac{n}{T} = \mu = const. \). Oznacza to, że przedział \([0, T]\) staje się półprostą \([0, \infty)\), ilość punktów w przedziale nieskończonym jest nieskończona (\(n=\infty\)), ale gęstość punktów (ilość punktów w jednostkowym przedziale) jest stała, ta sama, niezależna od tego gdzie przedział jednostkowy jest położony. Można mówić o jednorodnym rozkładzie punktów na półprostej. W sensie matematycznym, oś liczbowa spełnia to założenie, ale na przykład dla rozmów telefonicznych tak nie jest. Są takie okresy czasowe (dnia, roku) kiedy częściej dzwonimy i do nas częściej dzwonią.

Wykorzystajmy definicję parametru \(\lambda = n\cdot p\) w rozkładzie Poissona:

\(\lambda = n \cdot p = n \; \frac{t_2 - t_1}{T} = \frac{n}{N} (t_2 - t_1) = \mu (t_2 - t_1)\)

W odniesieniu do tych (ważnych) przykładów otrzymujemy następującą interpretację rozkładu Poissona: prawdopodobieństwa tego, że k punktów jest w przedziale czasowym \((t_1, t_2)\) określone jest przez wzór

Jeżeli gęstość punktów nie jest stała, wówczas należy dokonać zamiany

gdzie funkcja \(\mu(t) \ge 0\) charakteryzuje (niejednorodny) rozkład punktów na osi liczbowej. W takim przypadku mówimy o zmiennej losowej o niejednorodnym rozkładzie Poissona. Przykładem może być losowy proces emisji cząstek ze źródła scharakteryzowanego przez funkcję \(\mu(t)\). Wówczas prawdopodobieństwa tego, że k cząstek zostanie wyemitowanych w przedziale czasowym \((t_1, t_2)\) określone jest przez rozkład Poissona o parametrze \(\lambda\) danym przez powyższą całkę w Równaniu (8).

Procesy stochastyczne

Nim podamy formalną definicję procesu stochastycznego, rozważmy przykład który przybliży nam to pojęcie.

Przykład

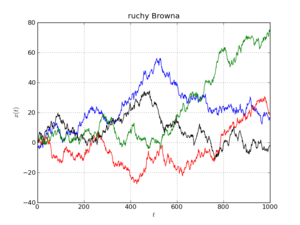

Cząstka Browna wykonuje ruch losowy. Można sobie wyobrazić, że przeprowadzamy doświadczenie z kolorową cząstką Browna w wodzie i śledzimy jej ruch w przestrzeni. Analizujemy ruch tylko w jednym kierunku poziomym, który oznaczymy jako oś X (rzutujemy ruch trójwymiarowy na jedną oś). Przedstawimy jednowymiarowy ruch takiej cząstki na wykresie. Oś pionowa przedstawia położenie cząstki, oś pozioma - czas. Położenie cząstki w chwili t oznaczymy jako \(\xi(t)\). Możemy tego typu doświadczenie powtarzać wielokrotnie (teoretycznie: nieskończenie wiele razy). W kolejnych doświadczeniach w chwili \(t=0\) cząstka może znajdować się w tym samym miejscu lub nie, to nie ma większego znaczenia. Załóżmy, że znajduje się w tym samym miejscu, nazwanym umownie \(x=0\), czyli warunek początkowy możemy zapisać w postaci \(\xi(0)=0\). Na rysunku przedstawione są wyniki czterech doświadczeń. Przedstawiamy cztery trajektorie cząstki Browna. W kolejnych doświadczeniach otrzymujemy inną trajektorię czastki. Gdybyśmy przeprowadzali coraz to więcej doświadczeń, trajektorie pokrywały by coraz to większą część płaszczyzny.

Chcemy zbadać własności wyników opisanego powyżej eksperymentu, w szczególności własności ruch cząstki Browna w określonym przedziale czasowym \((0, T], \; T > 0\). Przedstawione na rysunku cztery trajektorie to możliwe realizacje tego procesu. Ustalmy chwilę czasu, np. \(t=400\). Linia pionowa \(t=400\) na rysunku przecina trajektorie w czterech punktach. Te cztery punkty \(\xi(t=400)\) można potraktować jako możliwe wartości zmiennej losowej, którą oznaczymy \(\xi_{400}\). Jeżeli mamy tysiące takich trajektorii, to można standardowymi metodami statystyki obliczyc wartość średnią zmiennej losowej \(\xi_{400}\), jej wariancję, momenty statystyczne wyższego rzędu, itd. Możemy wybrać inną chwilę czasu, np. \(t=800\). Otrzymamy inną zmienną losową, którą oznaczymy \(\xi_{800}\). Możemy tak samo jak dla zmiennej losowej \(\xi_{400} \) obliczyć charakterystyki probabilistyczne zmiennej losowej \(\xi_{800} \). Możemy wybrać każdą inną chwilę czasu \(t=t_k\) otrzymując zmienną losową \(\xi_k\). Czytelnik domyśla się, że otrzymamy coś, co poprzednio nazwaliśmy wektorem losowym

Ale wektor ten ma nieskończenie wiele składowych, ponieważ czas \(t\) zmienia się w sposób ciągły i wskażnik \(k\) przyjmuje nieskończenie wiele wartości w przedziale \((0, T], \; T > 0\). Zagadnienie staje się wyjątkowo skomplikowane, ponieważ musimy badać wektor losowy o nieskończenie wielu składowych. Z rozdziału 4.8 wiemy, że aby taki wektor losowy w pełni scharakteryzować, powinniśmy wyznaczyć jego rozkłady prawdopodobieństwa

\(P_[[:Szablon:\mathbf \xi]](B_1, B_2, ..., B_n) = Pr(\xi_1 \in B_1, \xi_2 \in B_2, \ ..., \xi_n \in B_n) = P(\{\omega: \xi_1(\omega) \in B_1, \xi_2(\omega) \in B_2, \ ..., \xi_n(\omega) \in B_n)\)

lub dystrybuanty

\(F(x_1, x_2, ..., x_n) = Pr(\xi_1 \le x_1, \xi_2 \le x_2, ..., \xi_n \le x_n) \)

lub gęstości rozkładu prawdopodobieństwa

\( p(x_1, x_2, ..., x_n) = \frac{ \partial^n F(x_1, x_2, ..., x_n)}{\partial x_1 \partial x_2 ... \partial x_n} \)

Ale teraz n może zmieniać się od \(n=1\) to nieskończoności, \(n = 1, 2, 3, \dots \).

Zapis w Równaniu (9) oznacza zbór możliwych położeń cząstki Browna w różnych chwilach czasu indeksowanego przez wskaźnik \(k\). Bardziej precyzyjny zapis ma formę

Jest to przykład procesu stochastycznego. Należy uwypuklić dwa elementy tego procesu:

(1) dla ustalonej chwili czasu \(t=t_k\), wielkość \(\xi(\omega, t_k) = \xi_k(\omega)\) jest zmienna losową, czyli są to możliwe położenia cząstki w tej samej chwili czasu ale dla wielu doświadczeń, czyli różnych \(\omega \in \Omega\); wielkości \(\xi(\omega_1, 5), \; \xi(\omega_2, 5), \; \xi(\omega_3, 5), \; \xi(\omega_4, 5)\) to położenia cząstki w chwili \(t=5\) dla doświadczenia pierwszego, drugiego, trzeciego i czwartego.

(2) jedna trajektoria cząstki to jedna realizacja procesu stochastycznego, to znaczy jest to funkcja czasu dla ustalonego \(\omega \in \Omega\), czyli \(\xi(\omega_1, t)\) są to możliwe położenia cząstki dla pierwszego doświadczenia \((\omega = \omega_1)\) ale różnych chwil czasu.

Różne doświadczenia są indeksoweane przez \(\omega \in \Omega\), różne chwile czasu - przez \(t \in(0, T]\). W ogólności położenie jest indeksowane przez oba wskaźniki czyli \(\xi = \xi(\omega, t)\). Często opuszczany jest wskaźnik \(\omega\) (zwłaszcza przez nie-matematyków) i używa się uproszczonej notacji \(\xi(t)\). Po tym przykładzie możemy podać formalną definicję procesu stochastycznego.

DEFINICJA

Niech \((\Omega, \mathcal F, P)\) będzie przestrzenia probabilistyczną, \({\mathcal T}\) - zbiorem liczb rzeczywistych lub podzbiorem tego zbioru. Zbiór \({\mathcal T}\) będziemy interpretowali jako czas. Przez \(t\) oznaczymy element zbioru \({\mathcal T}\). Niech \((X, \mathcal B)\) będzie przestrzenia fazową. Funkcję

\(\xi: \Omega \times {\mathcal T} \to X\)

nazywamy procesem stochastycznym jeżeli dla każdego \(t\) oraz dla każdej liczby rzeczywistej \(x\) zbiór

\(\{\omega: \xi(\omega, t) \le x\} \in \mathcal F\)

jest zdarzeniem w przestrzeni probabilistycznej \(\Omega\).

Funkcja \(\xi = \xi(\omega, t) \) jest funkcją dwóch zmiennych: \(\omega\) oraz \(t\). Dla każdego ustalonego \(t\) funkcja \(\xi = \xi(\omega, t) \) rozważana jako funkcja argumentu \(\omega\) jest zmienną losową. Dla ustalonego zdarzenia elementarnego \(\omega\) funkcja ta nie jest losowa i nazywa sie realizacją procesu stochastycznego. Zatem proces stochastyczny można traktować jako rodzinę zmiennych losowych indeksowanych "czasem" \(t \in\mathcal T\) albo rodzinę realizacji zależną od parametru \(\omega \in \Omega\) .

UWAGI

1. Często przestrzeń fazową \(X\) nazywa sie przestrzenią stanów. Jeżeli \(\xi(\omega, t) =x\) mówimy, że układ jest w stanie \(x\in X\).

2. Jeżeli \(X\) jest zbiorem liczb rzeczywistych i \(\xi(\omega, t)\) może przyjmować dowolne wartości z tego zbioru, to proces stochastyczny nazywamy typu ciągłego (przez analogię do zmiennej losowej ciągłej).

3. Jeżeli \(X\) jest zbiorem liczb całkowitych lub naturalnych i \(\xi(\omega, t)\) przyjmuje wartości z tego zbioru, to proces stochastyczny nazywamy typu dyskretnego (przez analogię do zmiennej losowej dyskretnej).

4. Jeżeli "czas" jest dyskretny (indeksowany przez liczby całkowite lub naturalne) oraz \(X=R\), to proces stochastyczny nazywamy ciągiem losowym.

5. Jeżeli "czas" jest dyskretny (indeksowany przez liczby całkowite lub naturalne) oraz \(X\) jest zbiorem liczb całkowitych lub naturalnych, to proces stochastyczny nazywamy łańcuchem losowym.

Charakterystyki procesu stochastycznego

Analizując ruch Browna ja przykład procesu stochastycznego zauważyliśmy, że ten proces jest zbiorem nieskończenie wielu zmiennych losowych. Pamiętamy, że dla \(n\)-zmiennych losowych powinniśmy wyznaczyć łączny rozkład prawdopodobieństwa, czyli \(n\)-wymiarowy rozkład. W przypadku zbioru nieskończenie wielu zmienny losowych nie możemy oczekiwać, że określimy nieskończenie wymiarowy rozkład prawdopodobieństwa. Możemy starać się wyznaczyć rozkłady skończenie wymiarowe. Z praktycznego punktu widzenia, kilku-wymiarowe rozkłady są wystarczające. I tak zdefiniujemy rozklad jednowymiarowy procesu stochastycznego \(\xi(t)\):

CHARAKTERYSTYKI JEDNO-WYMIAROWE

1. Jednowymiarowa dystrybuanta

\(F(x, t) = Pr\{\xi(t) \le x\}\)

2. Jednowymiarowa gęstośc prawdopodobieństwa

\(p(x, t) = \frac{\partial F(x, t)}{\partial x}\)

3. prawdopodobieństwo tego, że w chwili \(t\) proces \(\xi(t)\) przyjmuje wartości z przedziału \((x_1, x_2]\) wynosi

\(Pr\{x_1 < \xi(t) \le x_2\} = Pr\{ \xi(t) \in (x_1, x_2]\} = \int_{x_1}^{x_2} p(x, t) \; dx\)

4. Warunek unormowania

\(\int_{-\infty}^{\infty} p(x, t) \; dx = 1 \)

5. Wartość średnia procesu \(\xi(t)\) w chwili \(t\) wynosi

\(m(t) = \langle \xi(t)\rangle = \int_{-\infty}^{\infty} x\; p(x, t) \; dx \)

6. Moment statystyczny k-tego rzędu procesu \(\xi(t)\) w chwili \(t\) wynosi

\(\langle \xi^k(t)\rangle = \int_{-\infty}^{\infty} x^k \; p(x, t) \; dx \)

7. Fluktuacje procesu \(\xi(t)\) w chwili \(t\) opisywane są przez moment centralny 20go rzędu:

\(\sigma^2(t) = \langle [\xi(t) - m(t)]^2\rangle = \langle [\xi(t) - \langle \xi(t)\rangle]^2\rangle = \langle \xi^2(t)\rangle - \langle \xi(t)\rangle^2 \)

Wielkość tę nazywamy też średnio-kwadratowym odchyleniem, wariancją lub średnio-kwadratowym przemieszczeniem (jeżeli dotyczy to dynamiki czastek).

8. Wartość średnia dowolnej funkcji \(g(\xi(t)) \) procesu \(\xi(t)\) w chwili \(t\) wynosi

\(\langle g(\xi(t)) \rangle = \int_{-\infty}^{\infty} g(x) \; p(x, t) \; dx \)

9. Jedno-wymiarowa funkcja charakterystyczna

\(C(\omega, t) = \langle e^{i\omega \xi(t)} \rangle = \int_{-\infty}^{\infty} e^{i\omega x} \; p(x, t) \; dx \)

Uwaga: tutaj \(\omega \in R\) jest dowolną liczbą rzeczywistą i nie ma nic wspólnego ze zdarzeniem elementarnym \(\omega \in \Omega\). Ponieważ historycznie zakorzeniło się oznaczenie dla funkcji charakterystycznej z argumentem \(\omega\), więc mamy jeszcze jeden powóod, aby używać uproszczonego zapisu \(\xi(\omega, t) = \xi(t)\) dla procesów stochastycznych.

CHARAKTERYSTYKI DWU-WYMIAROWE

1. Dwuwymiarowa dystrybuanta

\(F(x_2, t_2; x_1, t_1) = Pr\{\xi(t_2) \le x_2; \xi(t_1) \le x_1\}\)

2. dwuwymiarowa gęstośc prawdopodobieństwa

\(p(x_2, t_2; x_1, t_1) = \frac{\partial^2 F(x_2, t_2; x_1, t_1)}{\partial x_2 \partial x_1}\)

3. prawdopodobieństwo tego, że w chwili \(t_2\) proces \(\xi(t)\) przyjmuje wartości z przedziału \((a, b]\) oraz w chwili \(t_1\) proces \(\xi(t)\) przyjmuje wartości z przedziału \((c, d]\) wynosi

\(Pr\{a < \xi(t_2) \le b; c < \xi(t_1) \le d\} = Pr\{ \xi(t_2) \in (a, b]; \xi(t_1) \in (c,d] \)

\( =\int_{a}^{b} \int_{c}^{d} p(x_2, t_2; x_1, t_1) \; dx_2 \; dx_1 =\int_{a}^{b} dx_2 \int_{c}^{d} dx_1 \; p(x_2, t_2; x_1, t_1) \)

UWAGA: Czasami będziemy używali zapisu jak powyżej, aby uwidocznić w jakich granicach całkujemy po jakich zmiennych.

4. Warunek unormowania

\(\int_{-\infty}^{\infty} \int_{-\infty}^{\infty} p(x_2, t_2; x_1, t_1) dx_2 \; dx_1= 1 \)

5. Funkcja korelacji (funkcja korelacyjna) procesu stochastycznego

\(R(t_2, t_1) =\langle \xi(t_2)\xi(t_1)\rangle = \int_{-\infty}^{\infty} \int_{-\infty}^{\infty} \; x_2 \; x_1 \;p(x_2, t_2; x_1, t_1)\; dx_2\; dx_1 \)

Jeżeli

\(R(t_2, t_1) =\langle \xi(t_2)\xi(t_1)\rangle = \langle \xi(t_2)\rangle \; \langle\xi(t_1)\rangle \; \;\ \; dla \; \;\ t_2 \ne t_1\)

to proces nazywamy nieskorelowanym.

6. Funkcja kowariancji (kowariancja) procesu stochastycznego

\(C(t_2, t_1) =\langle [\xi(t_2) - m(t_2)][\xi(t_1) -m(t_1)]\rangle = \langle \xi(t_2)\xi(t_1)\rangle -m(t_2) m(t_1) = R(t_2, t_1)-m(t_2) m(t_1) \)

7. Wartość średnia dowolnej funkcji \(g \left(\xi(t_2, \xi(t_1)\right) \) procesu w różnych chwilach czasowych

\(\langle g(\xi(t_2), \xi(t_1) ) \rangle = \int_{-\infty}^{\infty} \int_{-\infty}^{\infty} g(x_2, x_1) \;p(x_2, t_2; x_1, t_1)\; dx_2\; dx_1 \)

8. Dwu-wymiarowa funkcja charakterystyczna

\(C(\omega_2, t_2; \omega_1, t_1) = \langle e^{i[\omega_1 \xi(t_1) + \omega_2 \xi(t_2)]} \rangle = \int_{-\infty}^{\infty} \int_{-\infty}^{\infty} e^{i(\omega_1 x_1 + \omega_2 x_2)} \;p(x_2, t_2; x_1, t_1)\; dx_2\; dx_1 \)

Oczywiście jeżeli ktoś woli pisać wskaźniki (2, 1) w odwrotnej kolejności (1, 2) to nie jest to zabronione, ale czasami ich uporządkowanie jest ważne, tak jak np. w punkcie 6.

Dodatkowe definicje

1. Przyrosty procesy stochastycznego \(\xi(t)\)

\(\Delta \xi(t_i) = \xi(t_i + \Delta t) - \xi(t_i) \,\)

\( d\xi(t) = \xi(t + dt) - \xi(t) \,\)

2. Proces stochastyczny \(\xi(t)\) nazywamy procesem o przyrostach niezależnych jeżeli dla dowolnych nieprzekrywających się przedziałów

\(t_0 < t_1 < \dots < t_n\)

zmienne losowe

\(\xi(t_0), \; \xi(t_1)-\xi(t_0), \; \xi(t_2)- \xi(t_1), \; \dots, \; \xi(t_n) - \xi(t_{n-1})\)

są niezależne.

Udowodnienie, że dany proces stochastyczny ma przyrosty niezależne jest często trudnym problemem. Czasami intuicyjne rozważania są pomocne w tej kwestii.

3. Procesy stacjonarne

(a) stacjonarność w węższym sensie

Jeżeli proces \(\xi(t)\) oraz proces \(\xi(t+\epsilon) \) mają te same n-wymiarowe rozkłady prawdopodobieństwa

\(p(x_n, t_n; \;x_{n-1}, t_{n-1}; \dots ; x_2, t_2; \;x_1, t_1) = p(x_n, t_n +\epsilon; \;x_{n-1}, t_{n-1}+\epsilon; \dots ; x_2, t_2+\epsilon; \;x_1, t_1+\epsilon)\)

dla dowolnego \(n\) i dowolnego \(\epsilon\).

W szczególności zachodzi

dla n=1:

\(p(x, t) = p(x, t+\epsilon)\;\)

Stąd wynika że 1-wymiarowa gęstość prawdopodobieństwa \(p(x, t) = p(x)\) nie zależy od czasu oraz wartość średnia procesu \(m(t)=\langle \xi(y) \rangle = m \;\) nie zależy od czasu.

dla n=2:

\(p(x_2, t_2; x_1, t_1) = p(x_2, t_2+\epsilon; x_1, t_1+\epsilon)\;\)

Stąd wynika że 2-wymiarowa gęstość prawdopodobieństwa

\(p(x_2, t_2; x_1, t_1)= p(x_2, x_1; t_2- t_1)\;\)

zależy od różnicy czasów \(t_2\) i \(t_1\). To z kolei implikuje że funkcja korelacji

\(R(t_2, t_1) =\langle \xi(t_2)\xi(t_1)\rangle = \int_{-\infty}^{\infty} \int_{-\infty}^{\infty} \; x_2 \; x_1 \;p(x_2, x_1; t_2- t_1)\; dx_2\; dx_1 = R(t_2 -t_1) \)

oraz

\(\langle \xi(t + \tau)\xi(t)\rangle = R(\tau)\)

(b) stacjonarność w szerszym sensie

Jeżeli wartość średnia procesu

\(m(t)=\langle \xi(y) \rangle = m \)

nie zależy od czasu oraz funkcja korelacji

\(\langle \xi(t + \tau)\xi(t)\rangle = R(\tau)\)

zależy od różnicy czasów \(t+ \tau\) i \(t\), wówczas proces stochastyczny \(\xi(t)\) nazywamy stacjonarnym w szerszym sensie. Oczywiście jeżeli \(\xi(t)\) jest stacjonarny w węższym sensie to jest także stacjonarny w szerszym sensie. Odwrotnie nie musi zachodzić.

4. Spektrum (widmo) mocy stacjonarnego procesu stochastycznego

\(S(\omega) = \int_{-\infty}^{\infty} e^{i\omega \tau} \; R(\tau) \; d\tau \)

Jest to transformata Fouriera funkcji korelacyjnej. Dla procesów niestacjonarnych pojęcie to nie jest dobrze zdefiniowane.

Z optyki wiemy, że kolor światła zależy od częstości promieniowania elektromagnetycznego. Kolor zielony czy fioletowy mają różne widma, ale krzywe widmowe zwykle są rozmyte i mają maksima w otoczeniu częstości odpowiadającej kolorowi zielonemu czy fioletowemu. Widmo światła białego nie ma wyróżnionych częstości. Inaczej mówiąc widmo to nie zależy od częstości. Przez analogię, proces stochastyczny którego widmo mocy nie zależy od częstości nazywamy białym szumem. Z powyższego wzoru można wnioskować, że jeżeli funkcja korelacyjna ma postać

\(\langle \xi(t + \tau)\xi(t)\rangle = R(\tau)= D \delta(\tau)\)

gdzie \(\delta(\tau)\) jest deltą Diraca, to widmo mocy nie zależy od częstości. Jeżeli wartośc średnia \(m(t) = m \) stacjonarnego procesu stochastycznego nie zeruje się, to zamiast funkcji korelacyjnej stosuje sie funkcję kowariancji i wówczas

\( C(t_2, t_1)= C(t_2, t_1) =\langle [\xi(t_2)-m][\xi(t_1)-m]\rangle = D \delta(t_2- t_1)\)

Z własności delty Diraca wiemy, że jeżeli \(t_2\ne t_1\) to \(\delta(t_2- t_1) =0\) czyli

\(C(t_2, t_1) = \langle \xi(t_2)\xi(t_1)\rangle -m^2 = \langle \xi(t_2)\xi(t_1)\rangle - \langle \xi(t_2)\rangle \; \langle\xi(t_1)\rangle =0 \; \; dla \; \; t_2\ne t_1\)

czyli

\(\langle \xi(t_2)\xi(t_1)\rangle = \langle \xi(t_2)\rangle \; \langle\xi(t_1)\rangle \; \; dla \; \; t_2\ne t_1\)

Stąd wnioskujemy, że biały szum jest nieskorelowanym procesem stochastycznym. Czasami mówi się, że jest to \(\delta\)-skorelowany szum. Nie oznacza to, że funkcja kowariancji każdego nieskorelowanego procesu jest dana przez deltę Diraca.

Charakterystyki pochodnej procesu stochastycznego

W teorii procesów stochastcznych istnieje kilka definicji ciągłości. Jest ciągłość prawie wszędzie (prawie na pewno); jest ciągłość według miary (w sensie prawdopodobieństwa) i jest ciągłość średnio-kwadratowa (w sensie średnio-kwadratowym). To ostatnie pojęcie jest dobrze znane fizykom z kursu mechaniki kwantowej.

DEFINICJA 1.

Proces stochastyczny \(\xi(t) \) jest ciągły średnio-kwadratowo w punkcie \(t_0\) jeżeli

\[\mbox{lim}_{h \to 0} \langle [\xi(t_0+h) - \xi(t_0)]^2 \rangle =0 \;\]

Taką definicję można stosować dla procesów stochastcznych dla których istnieje moment statystyczny drugiego rzedu, czyli

\[\langle \xi^2(t) \rangle < \infty\; \]

Oczywiście proces stochastyczny \(\xi(t) \) jest ciągły gdy jest ciągły w każdym punkcie \(t\).

Podobnie mozna zdefiniować pojęcie pochodnej procesu stochastycznego.

- DEFINICJA 2.

Proces stochastyczny \(\xi(t) \) jest różniczkowalny średnio-kwadratowo w punkcie \(t_0\) jeżeli istnieje taki proces stochastyczny \(\eta(t)\) że

\[\mbox{lim}_{h \to 0} \langle \left[ \frac{\xi(t_0+h) - \xi(t_0)}{h} - \eta(t_0)\right]^2 \rangle =0 \;\]

Proces \(\eta (t) \,\) nazywa się pochodną procesu \(\xi(t)\;\) i często oznacza jako

\[\eta(t) = \frac{d\xi(t)}{dt} = {\dot \xi}(t) \;\]

Podamy dwie ważne charakterystyki pochodnej procesu stochastycznego.

-

- Wartość średnia pochodnej procesu stochastycznego

Jeżeli

- \(\langle\xi(t)\rangle = m(t)\)

to

Czyli wartość średnia pochodnej procesu stochastycznego jest równa pochodnej wartości średniej tego procesu.

DOWÓD

\(\langle {\dot \xi(t)} \rangle = \lim_{h\to 0} \langle \frac{\xi(t+h) - \xi(t)}{h}\rangle = \lim_{h\to 0} \frac{1}{h} [\langle \xi(t+h)\rangle - \langle \xi(t)\rangle] = \lim_{h\to 0} \frac{1}{h} [m(t+h) - m(t)] = \frac{d m(t)}{dt} \)

Skorzystaliśmy tu z własności wartości średniej

\[\langle \alpha \xi_1(t) + \beta \xi_2(t) \rangle = \alpha \langle \xi_1(t)\rangle + \beta \langle \xi_2(t) \rangle \]

dla dowlolnych liczb \(\alpha\) i \(\beta\).

-

- Funkcja korelacyjna pochodnej procesu stochastycznego

Jeżeli

- \(\langle\xi(t_2)\;\xi(t_1)\rangle = R(t_2, t_1)\)

to

Czyli funkcja korelacyjna pochodnej procesu stochastycznego jest równa pochodnej mieszanej drugiego rzędu funkcji korelacyjnej procesu stochastycznego.

DOWÓD

\(\langle {\dot \xi(t_2)}{\dot \xi(t_1)} \rangle = \lim_{h\to 0 \ \epsilon \to 0} \; \; \langle \frac{\xi(t_2+h) - \xi(t_2)}{h} \cdot \frac{\xi(t_1+\epsilon) - \xi(t_1)}{\epsilon} \rangle = \lim_{h\to 0 \ \epsilon \to 0} \; \; \frac{1}{ h \epsilon} \langle [\xi(t_2+h) - \xi(t_2)] \cdot [\xi(t_1+\epsilon) - \xi(t_1)] \rangle \)

\( = \lim_{h\to 0 \ \epsilon \to 0} \; \; \frac{1}{ h \epsilon} \left\{ \langle \xi(t_2+h) \xi(t_1+\epsilon)\rangle - \langle \xi(t_2+h) \xi(t_1)\rangle - \langle\xi(t_2) \xi(t_1+\epsilon) \rangle + \langle \xi(t_2) \xi(t_1)] \rangle \right\} \)

\( = \lim_{h\to 0 \ \epsilon \to 0} \; \; \frac{1}{ h \epsilon} \left\{ R(t_2+h, t_1+\epsilon) - R(t_2+h, t_1) - R(t_2, t_1+\epsilon) + R(t_2, t_1) \right\} = \frac{\partial^2 R(t_2, t_1)}{\partial t_2 \,\partial t_1}\)

Ostatnia linia jest definicją pochodnej mieszanej drugiego rzędu funkcji \(R(t_2, t_1)\). Można wykazać, że proces stochastyczny \(\xi(t)\) jest różniczkowalny średnio-kwadratowo w punkcie \(t\) wtedy i tylko wtedy gdy istnieje pochodna mieszana

- \(\frac{\partial^2 R(t_2, t_1)}{\partial t_2 \,\partial t_1}\)

dla \(t_2=t\) i \(t_1=t\). Istnienie pochodnej oznacza to, że pochodna przyjmuje skończone wartości dla wszystkich \(t_1=t_2=t\).

Procesy Poissona

Proces urodzin

W rozdziale 5 podaliśmy kilka przykładów schematu Bernoulliego. Przypomnijmy przykład 3:

Rozważamy przedział liczbowy \([0, T]\). Z przedziału tego wybieram losowo jeden punkt, jedną liczbę. Ponieważ wszystkie liczby są "równo rozłożone", więc prawdopodobieństwo tego, że punkt ten jest w przedziale \((t_1, t_2)\subset [0, T] \) wynosi

\(P(A)= p = \frac{t_2 -t_1}{T}\)

Jeżeli wylosowany punkt jest w tym przedziale, uważam to za sukces. Wybieram teraz losowo n punktów z przedzialu \([0, T]\). Prawdopodobieństwo tego, że k z tych wszystkich n-punktów będzie w przedziale \((t_1, t_2)\subset [0, T] \) jest określone przez rozkład dwumianowy \(p_n(k)\). Jeżeli przedział \([0, T]\) będzie przedziałem czasowym, to w przedziale tym mam n losowych chwil czasu oraz \(k \le n\) losowych chwil czasu w przedziale \((t_1, t_2)\subset [0, T] \). Teraz dokonuję takiego samego przejścia granicznego jak w twierdzeniu Poissona

\(n \to \infty, \;\;\; p \to 0 \;\;\;\; \mbox{ale} \;\;n\cdot p = \lambda \)

co udaje mi się osiągnąć gdy założę że \(T \to \infty\) przy czym

\(\mu = \frac{n}{T}\)

jest stałą wielkością i oznacza ilość losowych punktów w jednostkowym przedziale, czyli gęstość losowo wybranych punktów na osi czasu. Przy takim skalowaniu otrzymam wyrażenie na parametr

\(\lambda = \mu (t_2 -t_1) \;\)

Przypiszmy teraz każdej losowej chwili czasu akt narodzin dziecka. Prawdopodobieństwo tego że w przedziale \((t_1, t_2) \) jest k-punktów odpowiada prawdopodobieństwu tego że w przedziale czasu \((t_1, t_2) \) urodziło się k dzieci. W ten sposób otrzymujemy losowy proces urodzin. Elementem losowym jest czas narodzin. Wynikiem jest liczba dzieci \(N(t) \) w pewnej chwili czasu \(t\). Rozkład prawdopodobieństwa jest dany przez rozklad Poissona:

Przyjmijmy teraz, że \(t_1 = 0\) i \(t_2 =t\). Wówczas \(t_2 - t_1 =t-0=t\) oraz

jest prawdopodobieństwem tego, że w przedziale czasu \((0, t)\) urodziło się k dzieci. Jeżeli liczbę urodzonych dzieci oznaczymy przez \(N(t)\) to otrzymamy proces stochastyczny nazywany procesem urodzin. Założymy, że \(N(0) = 0\). Oczywiście nie jest to bezwzględny wymóg, ale konwencja. Równie dobrze mógłbym badać dowolny inny stan początkowy \(N(0)\). Proces urodzin tak jak każda zmienna losowa o rozkladzie Poissona przyjmuje wartości całkowite nieujemne:

\(N(t) = \{0, 1, 2, \dots\} \)

Jeżeli \(N(t) = k\) to mówimy, że układ jest w stanie \(k\). Takie sformułowanie jest często stosowane przez fizyków, zwłaszcza w kontekście fizyki kwantowej, gdzie stanami mogą być poziomy energetyczne układów kwantowych. Proces urodzin odpowiadałby przejściu z jednego poziomu energetycznego do najbilższego wyższego poziomu energetycznego.Przejście do stanu o niższej energii nie jest opisane procesem urodzin, ale procesem urodzin i smierci.

Z materiału zawartego w Dodatku 20.5 wynika, że przyrosty procesu urodzin \(N(t_2) - N(t_1)\) oraz \(N(t_4) - N(t_3)\) na nieprzekrywających sie przedziałach \((t_1, t_2)\) oraz \((t_3, t_4)\) są zmiennymi losowymi niezależnymi. Jest to bardzo ważna własność procesu urodzin o poissonowskiej statystyce losowych chwil urodzin \(t_i\). Z Równania (13) widać, że przyrost procesu urodzin \(N(t_2) - N(t_1)\) jest stacjonarny, to znaczy, że prawdopodobieństwu tego że w przedziale czasu \((t_1, t_2) \) urodziło się k dzieci zależy od różnicy czasów \(t_2-t_1\), a nie zależy od tego gdzie te chwile czasu \(t_1\) i \(t_2\) są na osi czasu. Jeżeli tak jest, to w ogolnym przypadku mówimy, że proces stochastyczny ma przyrosty stacjonarne. Uwaga: sam proces nie jest stacjonarny ponieważ rozkład jednowymiarowy (14) zależy od czasu ale proces ma stacjonarne przyrosty!

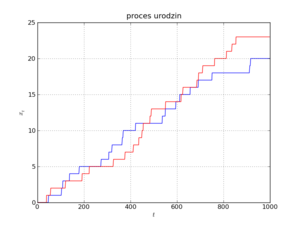

Na Rysunku pokazano dwie realizacje tego procesu. Realizacje te są nieciągłymi i niemalejącymi funkcjami czasu i są to funkcje schodkowe o skoku 1, przy czym skok następuje w losowych chwilach czasu \(t_i\) (zakładamy, że tylko jeden osobnik rodzi się w danym momencie czasu \(t_i\) i w rzeczywistości jest to prawda abstrahując od kwestii spornych przy cesarskim cięciu w przypadku wielodzietnych ciąży). Funkcje schodkowe można zapisać przy pomocy funkcji teta Heaviside'a, więc proces urodzin \(N(t)\) można przedstawić w elegenckiej matematycznej postaci:

Aby otrzymać jedną realizację procesu urodzin w przedziale czasu \([0, T]\), należy losowo wybrać w tym przedziale punkty \(t_i\) które są momentami urodzenia. Mówimy, że punkty te mają statystykę Poissona, mając na myśli ich jednorodne (ale losowe) rozłożenie na osi czasu, patrz Rozdział 6. Mimo że realizacje są funkcjami nieciągłymi (punktami nieciągłości są skoki), proces ten jest procesem ciągłym w sensie średnio-kwadratowym! Co to oznacza? Pogladowo oznacza to tyle, że jeżeli wybiorę jakiś punkt \(t\) na osi czasu, to realizacje będą ciagłe w tym punkcie. Inaczej mówiąc, prawdopodobieństwo tego, że punkt \(t\) "trafi" w nieciągłość (w skok schodka) jest zerowe!

Podsumowując, możemy to wszystko zebrać w matematyczną definicję procesu stochastycznego Poissona (lub poissonowskiego procesu urodzin).

DEFINICJA

Procesem Poissona \(N(t)\) nazywamy proces stochastyczny o następujących wlasnościach:

- Przestrzenią stanów jest zbiór liczb całkowitych nieujemnych, \(X=\{k\}_0^{\infty}\; = \{0, 1, 2, \dots \}\)

- \(N(0) = 0 \; \) (proces startujący z zera)

- \(N(t_2) - N(t_1)\; \) jest liczbą punktów w przedziale \((t_1, t_2)\)

- \(N(t)\) ma stacjonarne i niezależne przyrosty na nieprzekrywających się przedziałach o rozkładzie prawdopodobieństwa

WŁASNOŚCI PROCESU POISSONA

1. Wartość średnia

\(m(t) = \langle N(t) \rangle = \mu t\)

Z tej relacji mamy interpretację parametru

\(\mu = \frac{\langle N(t) \rangle}{t} \)

Parametr \(\mu\) to średnia liczba punktów w jednostce czasu lub średnia liczba urodzeń w jednostce czasu. Ten parametr może być oszacowany z danych statystycznych czy też z danych doświadczalnych.

2. Moment statystyczny drugiego rzędu

\(\langle N^2(t) \rangle = \mu^2 t^2 + \mu t\; \)

3. Stąd mamy relację dla fluktuacji procesu

\(\sigma^2(t) = \langle N^2(t) \rangle - \langle N(t) \rangle^2 = \mu t \; \)

4. Stąd mamy średnio-kwadratowe odchylenie

\(\sigma(t) = \sqrt{\mu t} \; \)

Ważna jest interpretacja tego wyniku: Fluktuacje procesu narastają liniowo w czasie. To oznacza, że im dłuższy jest czas tym odchylenia od wartości średniej mogą byc coraz większe. Można przeprowadzić następujące dewagacje:

Badam proces urodzin i przeprowadzam szereg symulacji komputerowych tego procesu. Otrzymuję wiele realizacji procesu urodzin. Z analizy tych realizacji mogę metodami statystyki otrzymać wartość średnią procesu. Oczekuję (coś to ma wspolnego z warościa oczekiwaną czyli wartościa średnią), że wiele realizacji bedzie przebiegać w pobliżu wartości średniej. Owszem to prawda, ale jednocześnie pojawiają mi się realizacje które daleko odbiegają od wartości średniej. Im dłuższy jest ten czas, tym większe odchylenia od wartości średniej mogę zaobserwować. Jest to własność, która w deterministycznym świecie nie występuje (deterministyczny świat nie jest światem rzeczywistym, jest jego idealizacją, bardziej lub mniej adekwatną). Do tego zagadnienia jeszcze powrócę, gdy będę rozważać procesy którym odpowiadaja zmienne losowe typu ciągłego.

Oczywiście powyższe relacje można (mutatis mutandis) podać dla przyrostów procesu Poissona:

1. Wartość średnia przyrostów procesu Poissona

\(\langle N(t_2) - N(t_1)\rangle = \mu (t_2-t_1)\)

2. Moment statystyczny drugiego rzędu dla przyrostów procesu Possona

\(\langle [N(t_2) - N(t_1)]^2 \rangle = \mu^2 (t_2-t_1)^2 + \mu (t_2-t_1) \; \)

3. Funkcja korelacyjna procesu Poissona

gdzie funkcja dwóch zmiennych \(\mbox{min}(x, y) \;\) oznacza wartość mniejszej liczby z dwóch liczb \(x\) i \(y\):

Z powyższych relacji wynika, że proces urodzin jest procesem skorelowanym.

Pokażemy, w jaki sposób można wyznaczyć postać funkcji korelacyjnej. Rozpatrzymy dwa przypadki pamiętając że \(N(t_0) = N(0) =0\):

(i) Niech \(t_2 > t_1 > t_0=0\). Przyrosty \(N(t_2) - N(t_1) \) oraz \(N(t_1) - N(t_0) \) są zmiennymi losowymi niezależnymi dla których

- \(\langle[N(t_2) - N(t_1)] [ N(t_1) - N(t_0)] \rangle = \langle N(t_2) - N(t_1) \rangle \cdot \langle N(t_1) - N(t_0) \rangle = \mu (t_2 -t_1) \; \mu t_1\)

Skorzystaliśmy tu z tego, że wartość średnia iloczynu zmiennych losowych niezależnych jest iloczynem wartości średnich zmiennych losowych niezależnych. Z drugiej strony, wymnożymy wyrażenia w nawiasach pamietając, że \(N(t_0) = N(0) = 0\) (proces Poissona startuje z zera). Wówczas otrzymamy

- \(\langle N(t_2) N(t_1) - N^2(t_1) \rangle = \langle N(t_2) N(t_1) \rangle - \langle N^2(t_1)\rangle =\mu (t_2 -t_1) \; \mu t_1\)

Stąd wynika, że

- \(\langle N(t_2) N(t_1) \rangle = \mu (t_2 -t_1) \; \mu t_1 +\langle N^2(t_1)\rangle = \mu (t_2 -t_1) \; \mu t_1 + \mu^2 t_1^2 + \mu t_1 = \mu^2 t_2 t_1 + \mu t_1 \; \; \; \; \mbox{dla} \; \; \; t_2 > t_1\)

(ii) Niech \(t_1 > t_2 > t_0=0\). Przyrosty \(N(t_1) - N(t_2) \) oraz \(N(t_2) - N(t_0) \) są zmiennymi losowymi niezależnymi. Możemy powtórzyć trzy kroki analogiczne do tych w powyższych trzech równanich otrzymując

- \(\langle N(t_1) N(t_2)\rangle = \mu (t_1 -t_2) \; \mu t_2 + \langle N^2(t_2)\rangle = \mu^2 t_1 t_2 + \mu t_2\; \; \; \; \mbox{dla} \; \; \; t_1 > t_2\)

Ponieważ

- \(\langle N(t_2) N(t_1)\rangle = \langle N(t_1) N(t_2)\rangle\)

to z powyższych równań otrzymujemy relację (17).

Rozkład prawdopodobieństwa Poissona (14) spełnia nastepujący układ równań ewolucji (ang. master equations), patrz RYSUNEK,

RYSUNEK

Słuszność tego układu równań można sprawdzić bezpośrednim rachunkiem, z jednej strony różniczkując wyrażenie dla \(p_k(t)\), z drugiej strony wstawiając wrażenia na \(p_k(t)\) oraz \(p_{k-1}(t)\). Równania te mają też jasną interpretację. W tym celu spojrzymy nieco inaczej na nasz proces. Mówimy, że układ jest w stanie \(k\) jeżeli

\(N(t) =k\;\)

Stan układu jest określony przez możliwe wartości populacji w danej chwili czasu, \(k=0, 1, 2, ....\). Zmiana stanu k układu w danej chwili czasu, opisywana przez tempo zmian czyli pochodną \(dp_k(t)/dt\), może zachodzić z dwóch powodów: albo stan k pojawia się ze stanu (k-1) ponieważ następuje akt narodzin, albo stan k znika i uklad przechodzi do stanu k+1 (ponieważ następuje akt narodzin). W wyrażeniu (20) wyraz \(\mu p_{k-1}(t)\;\) wchodzi ze znakiem dodatnim ponieważ stan k pojawia się ze stanu k-1; wyraz \(\mu p_{k}(t)\;\) wchodzi ze znakiem ujemnym ponieważ stan k znika i układ przechodzi w stan k+1 (ponieważ ktos sie urodził). Jest to nic innego jak równanie bilansu.

Proces urodzin i śmierci

W procesie urodzin, liczba osobników nie maleje. W rzeczywistości zachodzą też procesy śmierci, czyli ubytek osobników. Proces ten można uwględnić w relacji (27) w następujący sposób:

gdzie zmienne losowe \(\xi_i=\{1, -1\}\) są niezależne między sobą i są o identycznych rozkładach prawdopodobieństa:

\(P(\xi_i = 1) = p, \; \; \; P(\xi_i = -1) = q, \; \; \; p+q=1\)

Wartość zmiennej losowej \(\xi_i = 1\) odpowiada narodzinom (dodajemy jeden schodek), natomiast wartość zmiennej losowej \(\xi_i = -1\) odpowiada śmierci (odejmujemy jeden schodek). Jeżeli \(p=q=1/2\) to statystycznie mamy równowagę pomiędzy procesem urodzin i śmierci; jeżeli \(p > q\) to populacja powinna rozwijać się; jeżeli \(p < q\) to populacja powinna z czasem zamierać. W Równaniu (21) dodaliśmy składnik \(N(0)\), czyli stan początkowy populacji. Gdyby w chwili początkowej \(N(0)=0\), to pojawiłby się problem, gdyby w pierwszym kroku \(\xi_1=-1\), czyli powinien nastąpić akt śmierci. Ależ któż to miałby umrzeć, jeżeli nie ma żadnych osobników gdy \(N(0)=0\).

Proces urodzin i śmierci dobrze jest modelować i analizować opierając się na równaniach ewolucji dla rozkładu prawdopodobieństwa. Aby takie równania otrzymać, można uogólnić wywody przedstawione w poprzednim rozdziale 8.1. W "porządnej" teorii ogólniejsze równania ewolucji są wyprowadzane ściśle bazując na własnościach np. procesów Markowa. W procesie urodzin i śmierci zmiana stanu k następuje z 4 powodów (patrz RYSUNEK)

- stan k pojawia się ze stanu (k-1) ponieważ ktoś się urodził (przejście to opisuje parametr \(\lambda_{k-1}\) który w ogólnym przypadku zależy od stanu \(k-1\))

- stan k znika przechodząc w stan (k+1) ponieważ ktoś się urodził (przejście to opisuje parametr \(\lambda_{k}\) który w ogólnym przypadku zależy od stanu \(k\))

- stan k pojawia się ze stanu (k+1) ponieważ ktoś umarł (przejście to opisuje parametr \(\mu_{k+1}\) )

- stan k znika przechodząc w stan (k-1) ponieważ ktoś umarł (przejście to opisuje parametr \(\mu_{k}\) )

Równania bilansu przyjmują postać

W ogólnym przypadku, dla dowolnej zależności parametrów \(\lambda_k\) i \(\mu_k\) od \(k\), nie są znane rozwiązania tego układu równań. Szczególne przypadki są analizowane w książce: N. S. Goel and N Richter-Dyn, Stochastic models in biology (1974, Academic Press, New York).

Jeżeli \(N(t) = k\) to mówimy, że układ jest w stanie \(k\). Stanem tym może być liczba populacji, numer węzła sieci krystalicznej, stan energetyczny układu kwantowego. Powyższy proces urodzin i śmierci opisuje przejścia tylko pomiędzy sąsiednimi stanami \((k-1) - k - (k+1)\). Przejścia pomiędzy stanem \(k\) a stanem \((k+2)\) czy \((k-2)\) lu dalszymi nie są uwzględnione w tym opisie. W terminologi urodzin i śmierci, wyklucza się przypadki urodzin i/lub śmierci jednocześnie 2 osobników w tej samej chwili czasu.

Uogólnienia procesu Poissona

Uogólnienia procesu Poissona można konstruować wieloma metodami. Przykład jednej z metod jest przedstawiony w Rozdziale 8.2, we wzorze (21). Wzór ten można łatwo uogólnić dla przypadków gdy:

- zmiany stanów mogą zachodzic z dowolną amplitudą (w procesie urodzin możliwe były zmiany dyskretne o 1, w procesie urodzin i śmierci możliwe były dyskretne zmiany o 1 lub -1)

- amplituda zmian może być deterministyczna lub losowa (w procesie urodzin zmiana o 1 była deterministyczna, w procesie urodzin i śmierci zmiany były losowe o 1 lub -1)

Uogólnienie procesu Poissona będzie określone przez formułę

Proces ten zdefiniowalismy tak, aby jego wartość średnia \(\langle N(t)\rangle = 0\).

Zmienne losowe \( \{a_i\} \;\) są niezależne między sobą i są o identycznym (wspólnym, takim samym) rozkładzie prawdopodobieństwa określonym przez gęstość prawdopodobieństwa \(\rho (a)\;\). Zmienne losowe \( \{a_i\} \;\) mogą być dyskretne lub ciągłe, ich rozkład może być symetryczny lub niesymetryczny. Jeżeli jest symetryczny to gęstość prawdopodobieństwa \(\rho (a) =\rho (-a) \;\) jest funkcją parzystą (symetryczną ze względu na transformację \(a \to -a\)). W tym przypadku wartość średnia \(\langle a_i\rangle = 0\;\). W przypadku symetrycznej gęstości prawdopodobieństwa \(\rho (a)\;\), przyrosty procesu mogą być zarówno dodatnie jak i ujemne z tym samym prawdopodobieństwem. Przykładem może być gęstość prawdopodobieństwa

Jest ona przedstawiona na Rysunku. Wnioskujemy, że bardziej prawdopodobne są małe przyrosty procesu (dla małych wartości \(a_i\;\), gęstość jest duża, a całka z gęstości po danym przedziale jest prawdopodobieństwem tego że zmienna losowa \(a_i\;\) ma wartości z tego przedziału). Duże przyrosty procesu są mało prawdopodobne (dla dużych wartości \(a_i\;\), gęstość jest mała)

Jeżeli gęstość prawdopodobieństwa jest asymetryczna jak w poniższym przykładzie

to możliwe są tylko dodatnie przyrosty procesu \(N(t)\), ponieważ dla ujemnych \(a_i\), gęstość prawdopodobieństwa jest zero.

Powyższa konstrukcja procesu \(N(t)\) i przytoczone przykłady pokazują, że mamy nieskończenie wiele procesów Poissona. Problemem jest to, które mogą modelować rzeczywiste zjawiska. Ale to już inny problem.

Poissonowski ciąg impulsów: biały szum Poissona

Zwykle pod pojęciem szumu kryje się stacjonarny proces stochastyczny o zerowej wartości średniej. Mimo, że średnio jest zerowy, jego wpływ może być potężny. Proces urodzin Poissona nie jest ani stacjonarny ani o zerowej wartości średniej. Uzyskanie wartości średniej nie jest problemem. Zawsze możemy zdefiniować nowy proces będący różnicą procesu i jego wartością średnią:

- \({\tilde N}(t) = N(t) - m(t) = N(t) - \mu t\)

Wówczas

- \(\langle {\tilde N}(t) \rangle = 0\)

Ale ciągle nie jest to proces stacjonarny. z kolei (formalna) pochodna tego procesu

jest procesem stacjonarnym. Proces ten nazywa się poissonowskim ciągiem impulsów. Jedna z jego realizacji jest przedstawiona na Rysunku. Pionowe linie oznaczają impuls o nieskończonej amplitudzie. Nie jest to możliwe w realnym świecie, ale taka idealizacja jest usprawiedliwiona w przypadku dużych (ale skończonych) amplitud które bardzo krótko działają. Słowo "dużych" trzeba odnieść do innych wielkości układu. Podobnie jest z wyrażeniem "bardzo krótko". To musi być "bardzo krótko" w porównaniu z innymi skalami czasu w układzie. Każdy konkretny układ wymaga analizy skal czasu, energii, itp. Nie zawsze jest to proste zadanie, aby takie skale znaleźć.

Korzystając z wyników zawartych w Rozdziale 7.2 możemy obliczyć wsartość średnią procesu \(z(t)\) oraz jego funkcje korelacyjną.

Wartość średnia

Funkcja korelacyjna

Aby wyznaczyć funkcję korelacyjną procesu \(z(t)\), należy obliczyć pochodną mieszaną drugiego rzędu funkcji korelacyjnej procesu \(N(t)\). Funkcja korelacji procesu Poissona ma postać (patrz Rozdział 8.1)

\[R(t_2, t_1) = \langle N(t_2) N(t_1)\rangle = \mu^2 \;t_2 \;t_1 + \mu \; \mbox{min}(t_2, t_1)\]

gdzie funkcja dwóch zmiennych \(\mbox{min}(x, y) \;\) oznacza wartość mniejszej liczby z dwóch liczb \(x\) i \(y\):

\( \mbox{min} (x, y) = \left \{ {{x \; \; \mbox{if}\; \; x < y} \atop {y \; \; \mbox{if} \; \; y<x}} \right.\)

Obliczenie pochodnej mieszanej jest trudnm zadaniem dla studentów, dlatego przedstawie rachunki poniżej. Dobrze jest przedstawić funkcję

\(\mbox{min}(t_2, t_1) \;\) w innej postaci, a mianowicie

- \(\mbox{min}(t_2, t_1) = t_2 \theta(t_1 -t_2) + t_1 \theta (t_2 -t_1)\;\)

gdzie \(\theta(t)\;\) jest funkcją schodkowa Heaviside'a. Pochodna (dystrybucyjna) tej funkcji jest deltą Diraca,

- \(\frac{d\theta(t)}{dt} = \delta (t)\)

Obliczmy zatem pochodną cząstkową

- \(\frac{\partial \mbox{min}(t_2, t_1)}{\partial t_1} = t_2 \delta(t_1 -t_2) + \theta (t_2 -t_1) -t_1 \delta(t_2 -t_1) = \theta (t_2 -t_1)\;\)

ponieważ w sensie dystrybucyjnym zachodzi równość

- \( t_2 \delta(t_1 -t_2) = t_1 \delta(t_2 -t_1)\;\)

Obliczenie pochodnej wzgledem \(t_2 \) jest łatwe

- \(\frac{\partial^2 \mbox{min}(t_2, t_1)}{\partial t_2\,\partial t_1} = \frac{\partial \theta (t_2 -t_1)}{\partial t_2} = \delta(t_2 -t_1)\;\)

Możemy teraz wyznaczyć funkcję korelacyjną procesu \(z(t)\):

Wartość średnia procesu \(z(t)\) jest niezalezna od czasu, natomiast funkcja korelacyjna zależy tylko od różnicy czasów \(t_2-t_1\), a ze względu na własności delty Diraca mozna powiedzieć, że funkcja korelacyjna zależy tylko od bezwzględnej wartości różnicy czasów \(|t_2-t_1|\). Z tych dwóch własności wnioskujemy, że \(z(t)\) jest procesem stacjonarnym. Ponieważ jest on \(\delta\)-skorelowany, więc nazywamy go białym szumem poissonowskim.

Można zdefiniować biały szum poissonowski o zerowej wartości średniej:

- \(y(t) = z(t) - \mu \;\)

Wówczas

- \(\langle y(t)\rangle =0, \; \; \; \langle y(t_2)y(t_1) \rangle = \mu \delta(t_2-t_1)\)

Z uogólnionych procesów Poissona także można otrzymać biały szum który jest ich pochodną ze względu na czas.

Szum dychotomiczny

Błądzenie przypadkowe

W Rozdziale 6 omawialiśmy zmienne losowe Poissona, a w Rozdziale 8 omawialiśmy procesy Poissona, które są granicznym przypadkiem pewnej klasy schematów Bernoulliego: liczba niezależnych doświadczeń (prób) \(n\to \infty\) oraz prawdopodobieństwo sukcesu \(P(A_1) = p\) w jednym doświadczeniu zmierza do zera, \(p \to 0\), ale przejście graniczne jest dokonywane w taki sposób aby iloczyn \(n\cdot p = const. =\lambda\). Przykłady możliwe do realizowania takiego przejścia granicznego podaliśmy w Rozdziale 8. Tego typu przejścia granicznego nie mozna stosowac do doświadczen typu rzut monetą, ponieważ prawdopodobieństwo sukcesu \(P(A_1) = p\) w jednym doświadczeniu jest ustalone i nie może zmierzać do zera.

W następnym rozdziale podamy przykład innego przejścia granicznego prowadzącego do zupełnie nowej rodziny procesów stochastycznych, do procesów Wienera. Zarówno procesy Poissona jak i procesy Wienera stanowią podstawę wszelkich innych procesów stochastycznych. Można powiedzieć, że dowolny proces stochastyczny ma jakiś związek albo z procesem Poissona albo z procesem Wienera lub ich uogólnieniami.

Nim skonstruujemy proces Wienera, zdefiniujmy proces bładzenia przypadkowego. Rozpatrzymy raz jeszcze schemat Bernoulliego podobny do rzutu monetą zakładając możliwość posiadania sfałszowanej monety po to, aby prawdopodobieństwo wylosowania orła \(P(A_1)=p\) mogło być inne niż prawdopodobieństwo wylosowania reszki math>P(A_2)=q</math>.

RYSUNEK

Zdefinjujemy proces błądzenia przypadkowego w następujący sposób. Rozważmy nieskończoną jednowymiarową sieć (łańcuch) o strukturze periodycznej, o okresie \(L\). Węzły sieci oznaczymy liczbami całkowitymi \(\{\dots, -2, -1, 0, 1, 2, \dots \}\). Odległość między węzłami wynosi \(L\). Niech cząstka w chwili początkowej \(t=0\) znajduje się w węźle oznaczonym umownie \(r=0\). Cząstka co pewien ustalony czas \(T\) wykonuje krok albo w prawo (zdarzenie \(A_1\)) albo w lewo (zdarzenie \(A_2\)). Niech prawdopodobieństwo kroku w prawo wynosi \(p\), a kroku w lewo \(q\), czyli

\(P(A_1) =p, \; \; \; \; \;\;\;\;\; P(A_2) = q, \; \;\;\;\;\; \; \;p+q=1\)

Pytamy, jakie jest prawdopodobieństwo tego, że po \(n\) krokach cząstka jest w węźle o numerze \(r\). Czas \(t\) po \(n\)-krokach wynosi

\(t=nT\;\)

Dlatego czas \(t\) można utożsamiać z ilością kroków \(n\). Położenie w \(r\)-tym węźle wynosi

\(x=rL\;\)

Dlatego położenie \(x\) czas można utożsamiać z numerem węzła \(r\).

czyli położenie cząstki \(\xi(t)\; \) w chwili \(t\) zapiszemy jako

\(\xi(t) = \xi(nT)= x = r L \;\).

Załóżmy, że w \(n\)-krokach, \(k\)-kroków było w prawo (więc cząstka przesunęła się w prawo na odległość \(kL\)), a pozostałe \((n-k)\)-kroków było w lewo (więc cząstka przesunęła się w lewo na odległość \((n-k)L\)). Zatem położenie po \(n\)-krokach wynosi

\(x = k L - (n-k) L = (2k-n)l = rL, \; \; \; \; k=0, 1, 2, \dots, n\).

Stąd otrzymujemy relację

\(r=2k -n \;\;\; \mbox{lub} \;\;\; k=\frac{n+k}{2}, \; \; \;\ \; r= -n, -(n-1), -(n-2), \dots, (n-2), (n-1), n\)

Zauważmy, że tak sformułowany proces błądzenia przypadkowego jest schematem Bernoulliego o n próbach i k sukcesach. Więc prawdopodobieństwo tego, że po \(n\) krokach cząstka jest w węźle o numerze \(r\) dane jest przez rozkład dwumianowy:

W równaniu tym należy wstawić wyrażenia

\(k=\frac{n+r}{2} \;\;\; \mbox{oraz} \;\;\; n - k=\frac{n-r}{2}\)

Wówczas otrzymamy prawdopodobieństwo \(p_n(r)\) tego, że po n-krokach cząstka jest w węźle r:

Warunek unormowania ma postać

\(\sum_{r=-n}^n p_n(r) = 1\;\)

Jeżeli proces startuje z zerowego węzła, to znaczy \(\xi(0) = 0\), to

To są warunki początkowe dla prawdopodobieństw \(p_n(r) \;\).

Prawdopodobieństwa (31) spełniają równanie ewolucji (master equation) w postaci

gdzie zapisaliśmy zgrabnie warunek początkowy (32) przy pomocy delty Kroneckera \(\delta_{0,r}\), która równa się 1 gdy \(r=0\) oraz równa się zero gdy \(r\ne 0\).

Powyższe równanie ewolucji należy następująco interpretować: Z lewej strony równania mamy prawdopodobieństwa tego, że w chwili \((n+1)\) cząstka jest w położeniu \(r\). Z prawej strony równania mamy prawdopodobieństwa tego, że w chwili \(n\) cząstka była w położeniu \((r-1)\) i w następnym kroku z prawdopodobieństwem \(p\) przeskoczyła w prawo, czyli nastąpiło przejście \((r-1) \to r\) lub cząstka była w położeniu \((r+1)\) i w następnym kroku z prawdopodobieństwem \(q\) przeskoczyła w lewo, czyli nastąpiło przejście \((r+1) \to r\).

Dowód Równania (33) nie jest trudny. Należy zgodnie z oznaczeniami w Równaniu (31) wstawić poszczególne wyrażenia dla \(p_{n+1}(r), \; \; p_{n}(r-1)\) i \(p_{n}(r+1)\;\) oraz wykorzystać tożsamość z kombinatoryki dla kombinacji

\({n \choose m-1} + {n \choose m} = {n+1 \choose m}\)

gdzie \(m=(n+r+1)/2\;\). Tożsamość tę można sprawdzić bezpośrednim rachunkiem rozpisując symbol kombinacji jak w Równaniu (30).

Ponieważ znamy prawdopodobieństwa (31) lub równoważnie (30), możemy wyznaczyć momenty statystyczne dla błądzenia przypadkowego. Wygodniej jest wykowywac obliczenia stosując Równanie (30).

Średnie położenie

Wartość średnia procesu \(\xi(t)\), czyli wartość średnia położenia po \(n\)-krokach wynosi (patrz Równanie (30) i Równanie (31))

Zauważmy, że w symetrycznym przypadku, gdy \(p=q=1/2\), średnie położenie cząstki

\(\langle \xi(nT)\rangle=0\)

Jest to oczywiste, ponieważ z tym samym prawdopodobieństwo cząstka skacze w lewo i w prawo. Jeżeli \(p>q\) to cząstka częściej skacze w prawo niż w lewo i średnio cząstka przemieszcza sie w prawo. Z kolei gdy \(q>p\) to cząstka częściej skacze w lewo niż w prawo i średnio cząstka przemieszcza sie w lewo. Z fizycznego punktu widzenia, przypadek \(p\ne q\) oznacza, że istnieje jakaś przyczyna na to że cząstka dryfuje w jedna stronę. Tą przyczyną może być siła lub asymetria układu. Dlatego przypadek \(p\ne q\) nazywa się asymetrycznym błądzeniem przypadkowym lub błądzeniem przypadkowym z dryfem.

Średnio-kwadratowe przemieszczenie

Jeżeli mówimy o poruszających się cząstkach, to drugi moment centralny procesuy stochastycznego nazywamy często średnio-kwadratowym przemieszczeniem lub fluktuacjami położenia. Dla błądzenia przypadkowego otrzymujemy

\( \,\ \; \; \; \; \; \; \; \; = \sum_{k=0}^n [(2k-n)L - nL(2p-1)]^2\; {n \choose k} \cdot p^k \cdot q^{n-k} = 4n L^2p(1-p) \; \)

W symetrycznym przypadku, gdy \(p=q=1/2\), dyspersja ma postać

Podamy teraz ważną poglądową własność ruchu przypadkowego. Trajektorie cząstki (realizacje procesu) mogą bardzo różnie przebiegać, czasami znacznie się różnić. Jednak zdecydowana większość trajektorii fluktuuje wokół wartości średniej i jest w przedziale:

\(\xi(t) \in [\langle \xi(t)\rangle - \sigma(t), \langle \xi(t)\rangle + \sigma(t)] \;\)

W przypadku symetrycznym większość trajektorii jest w przedziale:

\(\xi(nT) \in [ - \sigma(nT), + \sigma(nT)] = [-L\sqrt{n}, L\sqrt{n}] \;\)

Zauważmy, że gdy ilość kroków \(n\) rośnie (czas \(t=nT\) rośnie) to narastają też fluktuacje położenia. Innymi słowy, trajektorie mogą rozbiegać sie coraz bardziej od wartości średniej. Ta rozbieżność jest pierwiastkowa z ilością kroków: \(\propto \sqrt{n}\).

Powyżej używałem różnych zapisów tej samej wielkości. Pamiętajmy, że położenie cząstki w chwlili \(t\) jest opisane przez \(\xi(t)\), czas \(t\) utożsamiamy z ilościa kroków \(n\), z kolei położenie cząstki po \(n\)-krokach oznaczyliśmy przez \(r\). W praktyce, najprościej jest wyliczyć wartość średnią i wariancję używając wyrażeń z sumą po \(k\). Wówczas można wykorzystać wzór na dwumian Newtona

\( (x+y)^n = \sum_{k=0}^n {n \choose k} \cdot x^k \cdot y^{n-k} \; \)

Różniczkując (jednokrotnie i dwukrotnie) powyższy wzór względem x, przyjmująć \(x=p\) oraz \(y=q=1-p\) otrzymamy warażenia na występujące powyżej sumy. Dla przykładu obliczmy sumę

\( S_1 = \sum_{k=0}^n k \; {n \choose k} \cdot p^k \cdot q^{n-k} \;\)

Zróżniczkujmy obustronie dwumian Newtona względem x:

\( n(x+y)^{n-1} = \sum_{k=0}^n k \; {n \choose k} \cdot x^{k-1} \cdot y^{n-k} \;\)

Wyrażenie to mnożymy obustronnie przez \(x\), następnie podstawiamy \(x=p , \; y=q\) pamiętając że \(p+q=1\;\). W rezultacie otrzymamy

\( np = \sum_{k=0}^n k \; {n \choose k} \cdot p^k \cdot q^{n-k} =S_1\;\)

Dwukrotne różniczkowanie ze względu na \(x\) pozwala na wyliczenie sum zawierających \(k(k-1)=k^2-k\), ale sumę zawierającą \(k\) własnie wyliczyliśmy. Dlatego tez można wyliczyc sumę zawierającą \(k^2\). Tym sposobem możemy obliczyć momenty dowolnego rzędu dla błądzenia przypadkowego.

UWAGi:

1. Powyższe rozważania mozna uogólnić na ruch cząstki na płaszczyźnie (ruch dwu-wymiarowy) i w przestrzeni (ruch trój-wymiarowy).

2. Można rozważać także przeskoki o 2 (3, 4, ...) węzły.

3. Można dokonac uogólnienia zakładając, że czastka z prawdopodobieństwem \(p_1\) przeskakuje w prawo, z prawdopodobieństwem \(p_2\) przeskakuje w lewo oraz z prawdopodobieństwem \(p_3\) nie przeskakuje (czeka).

4. Rozważany w Rozdziale 8.2 proces urodzin i śmierci też opisuje błądzenie przypadkowe cząstki: przejściu (narodziny) \(k \to k+1\) odpowiada przeskok w prawo z węzła \(k\) do węzła \(k+1\), podobnie przejściu (śmierci) \(k \to k-1\) odpowiada przeskok w lewo z węzła \(k\) do węzła \(k-1\). Jest to rozszerzenie procesu urodzin i śmierci ponieważ przestrzeń stanów zawiera wszystkie liczby całkowite numerujące węzły sieci (dla procesu urodzin i śmierci przestrzeń stanów to liczby całkowite nieujemne).

Proces dyfuzji - proces Wienera

Proces Wienera jest, obok procesu Poissona, najważniejszym procesem stochastycznym. Jest on punktem wyjścia nieskończenie wielkiej gamy procesów stochastycznych o ciągłych realizacjach, w odróżnieniu od realizacji procesu Poissona, które są nieciągłymi funkcjami czasu. Tak jak procesu Poissona jest granicznym przypadkiem pewnej klasy schematów Bernoulliego, tak i proces Wienera jest również granicznym przypadkiem pewnej klasy schematów Bernoulliego. Czytelnik oczywiście domyśla się, że musi to być inne przejście graniczne. To przejście graniczne dokonamy dla błądzenia przypadkowego z poprzedniego rozdziału. Jak wiemy, błądzenie przypadkowe jest także schematem Bernouliego.

Przejście graniczne w procesie błądzenia przypadkowego

Błądzenie przypadkowe jako proces stochastyczny posiada poważny (realny) mankament: przejścia z jednego węzła na sąsiedni węzeł odbywają się dokładnie co okres czasu \(T\) tak jak tykanie porządnego zegara kwarcowego. Idealne skoki o odległość \(L\) też są fikcją fizyczną. Tym niemniej, proces taki odgrywał, odgrywa i będzie odgrywał bardzo ważna rolę nie tylko w naukach przyrodniczych, ale także ekonomicznych i socjologicznych.

Dokonajmy takiego przejścia granicznego dla błądzenia przypadkowego , aby cząstka mogła skakać coraz częściej i mogła robić dowolnie małe skoki. Innymi słowy, skalujemy tak aby

- Tego typu przejście graniczne może być realizowane na nieskończenie wiele sposobów. Co mam na myśli? Przypomnijmy przejście graniczne realizowane dla procesu Poissona. Tam \(n\to \infty,\; \; \; p\to 0\), ale w taki sposób aby \(n\cdot p = const. = \lambda\) lub też

\(n\to \infty,\; \; \; T\to \infty\), ale w taki sposób aby gęstość punktów \(n/T = \mu\;\) była stała. Postępując analogicznie, powinniśmy żądać, aby iloraz \(L/T\) był stały lub ogólniej aby iloraz

- \(\frac{L^a}{T^b} = const.\)

gdzie \(a\) i \(b\) są skalującymi wykładnikami. W zależności od ich wartości, możemy dokonywać różnych (bardziej lub mniej uzasadnionych lub bardziej lub mniej realnych) przejść graniczych. Zauważmy, że najprostszy wybór \(a=b=1\;\) daje skalowanie

- \(\frac{L}{T} = \frac{ \Delta x}{\Delta t} = const. =v\)

gdzie \(v\;\) ma wymiar prędkości [m/s]. Ktoś powie: wspaniale, prędkość to "dobrze zadomowione" pojęcie. Więc tak skalujmy. Wybierzemy inną drogę. Będziemy dokonywali przejścia granicznego (37), ale bez konkretnego skalowania tak długo, jak to możliwe.

Startujemy z Równania (33) dla prawdopodobieństwa \(p_n(r)\) tego, że po \(n\)-krokach cząstka jest w węźle \(r\), lub inaczej mówiąc, w chwili \(t=nT\;\) jest w położeniu \(x=rL\;\). Wprowadzimy nowe oznaczenie na to prawdopodobieństwo

Z relacji

\(x = rL = r \Delta x, \; \; \; \; \; \; t=nT = n \Delta t\)

otrzymamy

\(r = \frac{x}{\Delta x}, \; \; \; \; \; \; n = \frac{t}{\Delta t}\)

Przy takich oznaczeniach

\(p(r, n) = p\left(\frac{x}{\Delta x}, \frac{t}{\Delta t}\right)\; \)

Zdefiniujemy gęstość prawdopodobieństwa (prawdopodobieństwo na jednostkę długości) za pomocą relacji

Gęstość prawdopodobieństwa \(f(x, t)\) powinna być unormowana, to znaczy

\(\int_{-\infty}^{\infty} f(x, t) \; dx =1\)

Faktycznie można to pokazać dokonując przejścia granicznego w Równaniu (xx--CrossReference--eqn:10.32-equation--xx). Otrzymamy wówczas jawną postać gęstości \(f(x, t)\). Jednak nasz cel jest inny: my chcemy otrzymać graniczną postać równania ewolucji (33):

\(p_{n+1}(r) = p \cdot p_n(r-1) + q \cdot p(r+1) \)

które przedstawimy w postaci (patrz Równanie (38))

\(p(r, n+1) = p \cdot p(r-1, n) + q \cdot p(r+1, n) \)

Ustalamy wartości czasu \(t\) i położenia \(x\) cząstki, natomiast zmniejszamy \(\Delta t\) oraz \(\Delta x\). To jest możliwe, gdy jednocześnie liczba kroków \(n\to \infty\) oraz numer węzła określający położenie \(|r| \to\infty\). Korzystając z definicji (38), powyższe równanie transformuje sie do postaci

\(f(x, t + \Delta t) = p \cdot f(x - \Delta x, t) + q \cdot f(x + \Delta x, t) \)

Aby do końca przeprowadzić przejście graniczne (37), rozwiniemy funkcje \(f(x, t + \Delta t), \; \; f(x - \Delta x, t), \; \; f(x + \Delta x, t)\) w szereg Taylora otrzymując wyrażenie

\( = p\left\{ f(x, t) - \frac{\partial f(x, t)}{\partial x} \Delta x + \frac{1}{2} \frac{\partial^2 f(x, t)}{\partial x^2} (\Delta x)^2 - \frac{1}{3!} \frac{\partial^3 f(x, t)}{\partial x^3} (\Delta x)^3 + \dots \right\} \)

\( + q \left\{ f(x, t) + \frac{\partial f(x, t)}{\partial x} \Delta x + \frac{1}{2} \frac{\partial^2 f(x, t)}{\partial x^2} (\Delta x)^2 + \frac{1}{3!} \frac{\partial^3 f(x, t)}{\partial x^3} (\Delta x)^3 + \dots \right\} \)

PRZYPADEK SYMETRYCZNY

Aby wybrać poprawne skalowanie, musimy najpierw rozpatrzeć przypadek symetryczny błądzenia przypadkowego

\(p=q = \frac{1}{2}\;\)

Wówczas otrzymamy równanie

\( \frac{\partial f(x, t)}{\partial t} \Delta t+ \frac{1}{2} \frac{\partial^2 f(x, t)}{\partial t^2} (\Delta t)^2 + \dots = \left\{ \frac{1}{2} \frac{\partial^2 f(x, t)}{\partial x^2} (\Delta x)^2 + \frac{1}{4!} \frac{\partial^4 f(x, t)}{\partial x^4} (\Delta x)^4 + \dots \right\} \)

Dzieląc obustronie to równanie przez \(\Delta t\) otrzymamy

Jeżeli teraz

to otrzymamy "dziwny" przypadek

\( \frac{\partial f(x, t)}{\partial t} =0 \)

Stąd wynika, że gęstość \(f(x, t)\) nie zależy od czasu. To z kolei oznacza, że prawdopodobieństwo tego, że cząstka jest w przedziale np. \([2, 5]\) nie zmienia się w czasie. To nie może być prawdą. Pamiętamy, że w chwili \(t=0\), cząstka była w położeniu \(x=0\) (cząstka była w węźle 0). Skoro tak, to prawdopodobieństwo tego, że była w przedziale np. \([2, 5]\) wynosi 0. A to nie zmienia się, więc nigdy cząstka nie mogłaby znależć sie w tym przedziale. To jest w sprzeczności z wynikami, jakie uzyskalismy dla błądzenia przypadkowego. Dlatego też skalowanie (42) nie jest rozsądne. Nie jest dobrze jak znikają wszystkie wyrazy po prawiej stronie Równania (41). Jeżeli chcemy uzyskać nietrywialny wynik, załóżmy takie skalowanie, aby chociaż jeden wyraz po prawej stronie Równania (41) nie znikał. To nam sugeruje następujące skalowanie

Teraz Równanie (41) redukuje sie do postaci

Równanie to nazywa się równaniem dyfuzji i opisuje ono proces który nazywa się procesem dyfuzji. Jest to równanie różniczkowe cząstkowe drugiego rzędu, parabolicznego typu. Parabolicznego - ponieważ z lewej strony jednokrotnie różniczkujemy względem \(t\) (oznaczmy taką operację y), a z prawej strony dwukrotnie różniczkujemy względem \(x\) (oznaczmy taką operację z), czyli symbolicznie \( y=D z z = D z^2\), a to jest równanie paraboli (za takie wyjaśnienie matematycy mnie zjedzą). Ponieważ jest to równanie różniczkowe, więc musimy sformułować warunek początkowy \(f(x, 0)\). Wiemy, że w chwili \(t=0\), cząstka jest w położeniu \(x=0\), czyli proces stochastyczny \(\xi(t)\) startuje z zera, \(\xi(0) = 0\), to z Rozdziału 4 wiemy że dla zmiennej losowej \(\xi =0\) dystrybuantą jest funkcja schodkowa Heaviside'a \(F_{\xi}(x)=\theta(x-0)\), a odpowiadająca jej gęstość prawdopodobieństwa jest pochodną dystrybuanty, czyli delta Diraca` \(\delta(x-0)\). Dlatego też warunek początkowy dla cząstki startującej z zera ma postać

Ponieważ gęstość rozkładu prawdopodobieństwa \(f(x, t)\) zależy także od zmiennej przestrzennej, potrzebne sa także warunki brzegowe. Funkcja \(f(x, t)\) jest unormowana do 1, więc powinna dostatecznie szybko znikać w nieskonczoności. Istnieją kontrprzykłady na to, ale dla rzeczywistych układów

Parametr \(D\) w równaniu dyfuzji nazywa się współczynnikiem dyfuzji i dla cząstki błądzącej ma wymiar \([m^2/s]\). W ogólnym przypadku, wymiarem jest kwadrat procesu stochastycznego \(\xi^2(t)\) podzielony przez argument \(t\), czyli \([\xi^2]/[t]\).

Unormowanym rozwiązaniem równania dyfuzji jest następujaca funkcja

Jest to funkcja Gaussa opisujaca zmienne losowe normalne lub gaussowskie. W takim razie, w granicznym przypadku błądzenie losowe cząstki jest procesem gaussowskim lub procesem o rozkładzie normalnym (nazwa 'proces normalny' brzmi myląco). Można udowodnić, że proces ten ma niezależne przyrosty na nieprzekrywających się przedziałach \([t_i, \; t_{i+1}]\).

Znajomość gęstości rozkładu prawdopodobieństwa \(f(x, t)\) pozwala na wyznaczenie momentów statystycznych procesu. Ponieważ \(f(x, t)\) jest funkcja parzystą, więc wartość średnia procesu jest zero. Wariancja procesu

\(\sigma^2(t) = 2Dt\;\)

Proces, który w przypadku symetrycznym otrzymaliśmy jako proces graniczny błądzenia przypadkowego nazywa się procesem Wienera i oznacza przez \(W(t)\). W naszych rozważaniach opisuje on losowe położenie cząstki błądzącej czyli \(W(t)\) jest położeniem cząstki w chwili \(t\). Oczywiście w zależności od zagadnienia, interpretacja \(W(t)\) może byc inna. Podamy teraz formalną definicję tego procesu.

PROCES WIENERA \(W(t)\)

1. Proces stochastyczny \(W(t)\) jest procesem rzeczywistym

2. \(W(0)=0\) (proces startuje z zera)

3. Proces \(W(t)\) ma stacjonarne i niezależne przyrosty na nieprzekrywających się przedziałach

4. \(W(t)\) jest procesem Gaussa o zerowej wartości średniej

i wariancji przyrostów

Zauważmy, że własności 1, 2 i 3 są podobne do własności procesu Poissona. ale na tym podobieństwa sie kończą.

Przyrost \(W(t_2) - W(t_1)\) jest zmienna losową gaussowską o zerowej wartości średniej i wariancji \( = 2D(t_2 - t_1) \). Więc jego rozkład prawdopodobieństwa ma postać

Przyjmując \(t_1=0\) oraz \(t_2=t\) otrzymamy gęstość prawdopodobieństwa w postaci

gdzie funkcja \(f(x, t) \) dana jest przez Równanie (47).

Prawdopodobieństwo tego, że w chwili \(t\) cząstka jest w przedziale \([a, b]\) dane jest przez wzór

Czytelnik zauważy, że niekonsekwentnie piszę czasami przedział domknięty \([a, b]\), a czasami przedział otwarty \((a, b)\). W tym przypadku to jest bez różnicy ponieważ

- \(Pr\{W(t) \in (a, b)\} = Pr\{W(t) \in [a, b]\} = Pr\{W(t) \in [a, b)\} = Pr\{W(t) \in (a, b])\} \)

Proces Wienera został otrzymany z procesu błądzenia przypadkowego jako graniczny przypadek: skoki są coraz mniejsze i coraz częstsze. Rozpatrzmy realizacje błądzenia przypadkowego w określonym przedziale czasu \([0, t]\). W przedziale tym wybrana realizacja posiada określoną ilość skoków w których funkcja ta jest nieróżniczkowalna. Przy skalowaniu skoki są coraz mniejsze, ale jest ich znacznie więcej. Więc w przedziale czasu \([0, t]\) realizacja posiada znaczniej więcej punktów, w których jest nieróżniczkowalna. W granicy, wielkość skoków dąży do zera, ale ich ilość dąży do nieskończoności. Oznacza to, że realizacja staje się funkcją ciągłą (wysokość skoków dąży do zera), ale jednocześnie nigdzie nie jest różniczkowalna (liczba skoków dąży do nieskończoności). Jest to przykład wyjątkowo dziwnej funkcji. Takiej funkcji nie możemy narysować, ale to co opisałem powyżej powinno wyrobić w nas intuicję o własnościach realizacji procesu Wienera. Matematycy (jak zwykle) dowodzą to ściśle, a fizycy to czują i wiedzą dlaczego tak jest.

Nieróżniczkowalność procesu Wienera można zrozumieć "bardziej analitycznie". Niech we wzorze (xx--CrossReference--eqn:11.12-equation--xx) czas \(t_1=t\) oraz \(t_2=t+\Delta t\). Otrzymamy przyrost procesu Wienera

- \(\Delta W(t) = W(t+\Delta t) - W(t) \;\)

i wzór (xx--CrossReference--eqn:11.12-equation--xx) ma postać

Dlatego można wnioskować, że w sensie średnio-kwadratowym

\(\Delta W(t) \sim \sqrt{ \langle [\Delta W(t)]^2 \rangle } \sim \sqrt{ \Delta t} \)

Stąd otrzymamy

- \(\frac{\Delta W(t)}{\Delta t} \sim \frac{1}{\sqrt{ \Delta t}} \to \infty \; \; \; \; \mbox{gdy} \; \; \; \Delta t \to 0 \)

Ponieważ iloraz różnicowy jest w granicy rozbieżny, pochodna nie istnieje. Inaczej mówiąc, proces ten nie jest różniczkowalny (nawet w sensie średnio-kwadratowym). Mimo to fizycy chętnie posługują się pochodną procesu Wienera i ku zdziwieniu "klasyków" otrzymują prawidłowe wnioski o realnym świecie. Do tego problemu powrócimy w następnym rozdziale.

FUNKCJA KORELACYJNA PROCESU WIENERA

Przytoczyłem pewną własność procesu Wienera, a mianowicie tę, że jest on procesem o niezależnych przyrostach na nieprzekrywających się przedziałach. Niektórzy autorzy wkładają tę własność do definicji procesu Wienera. Traktując proces Wienera jako graniczny przypadek błądzenia przypadkowego, tę własność można udowodnić. Podobną własność ma także proces Poissona. Dla procesu Poissona udowodniliśmy to, korzystając z uogólnionego schematu Bernoulliego.

Twierdzenie: Funkcja korelacyjna procesu Wienera ma postać

gdzie funkcja \(\mbox{min}(t_2, t_1) \;\) jest zdefiniowana w Równaniu (18) i oznacza mniejszą z dwóch liczb \(t_2, \; t_1\). Funkcja korelacyjna procesu Wienera zawiera tę samą specyficzną funkcję \(\mbox{min}(t_2, t_1) \;\). Funkcja ta pojawia się we wszystkich procesach o niezależnych przyrostach na nieprzekrywających się przedziałach. Jeszcze raz pojawi się ona w teorii procesów Levy'ego.

Dowód: (i) Niech \(t_2 > t_1 > t_0=0\). Przyrosty \(W(t_2) - W(t_1) \) oraz \(W(t_1) - W(t_0) \) są zmiennymi losowymi niezależnymi dla których